从DPU产业现状,谈英伟达DPU架构

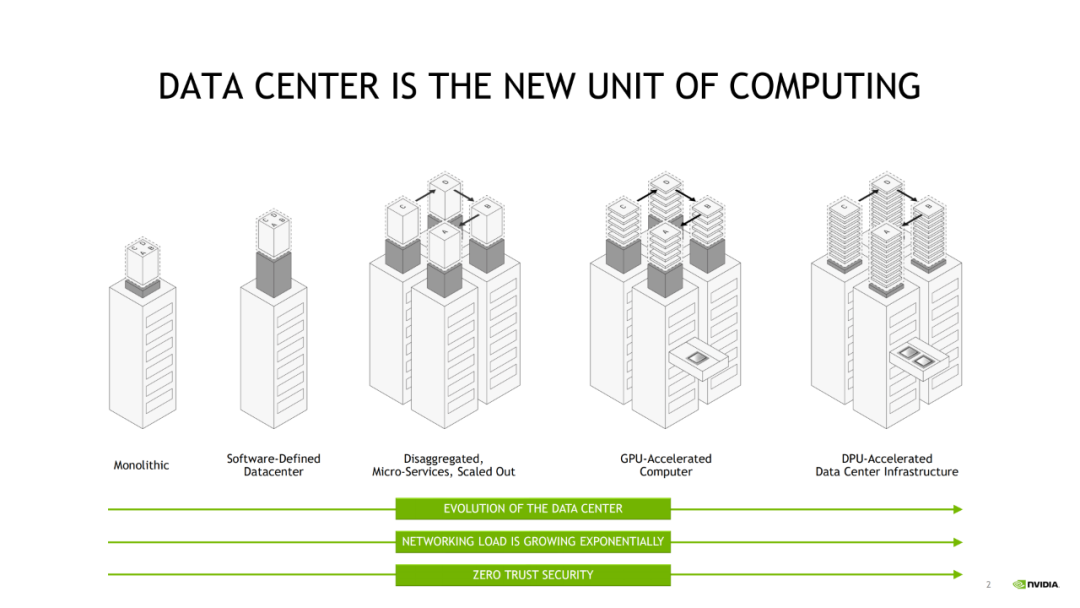

我们生活在一个每天都会产生大量数据的数字信息时代。随着物联网设备、自动驾驶汽车、联网家庭和联网工作场所数量的不断增加,数据中心的数据愈加趋向饱和。因此,需要一种解决方案,使数据中心能够处理不断增加的进出和通过数据中心传输的数据量。

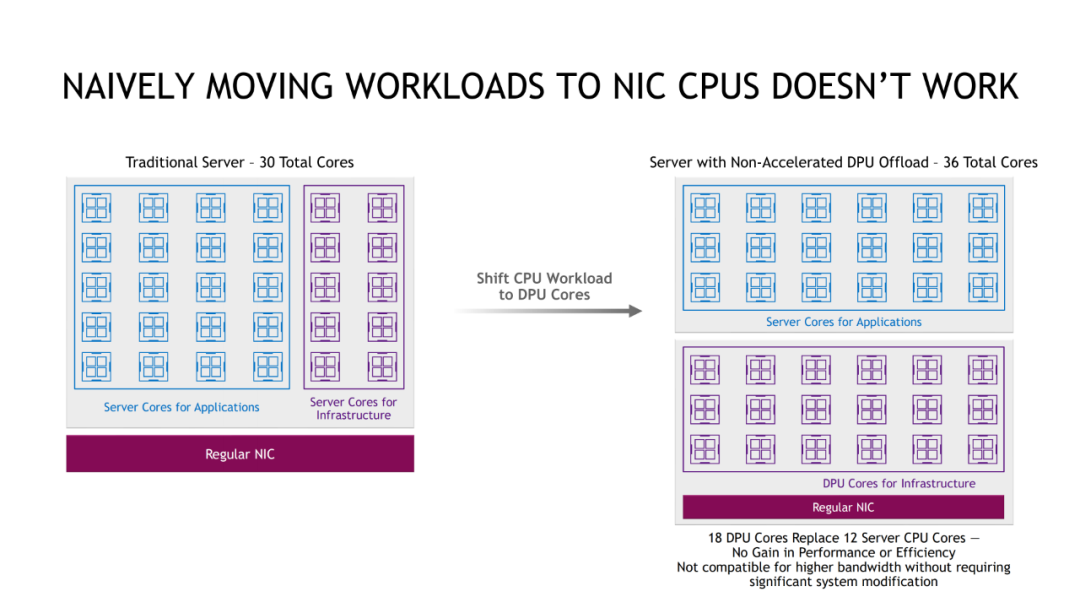

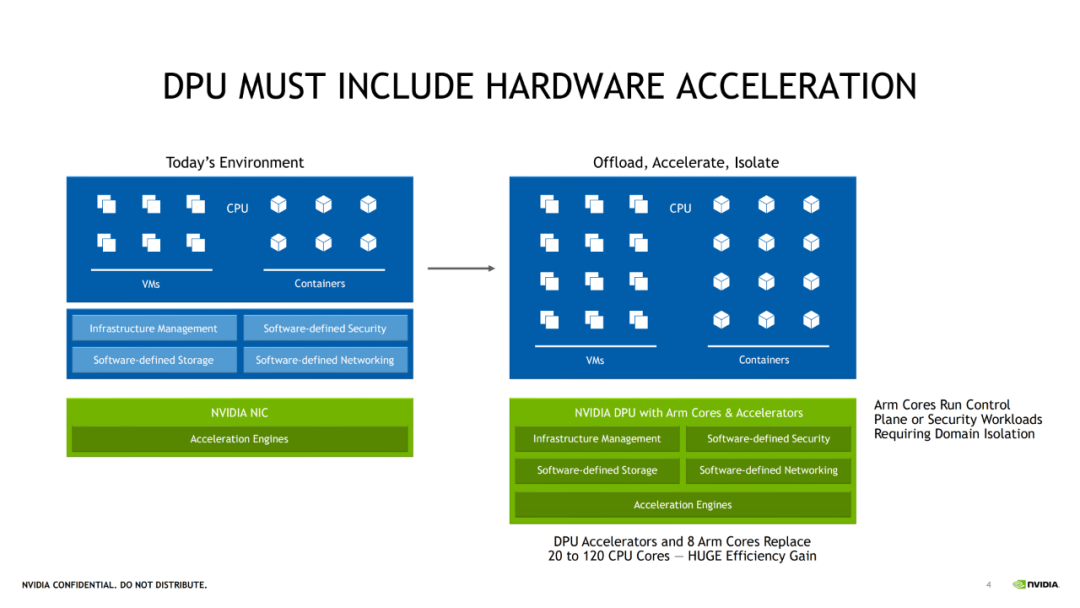

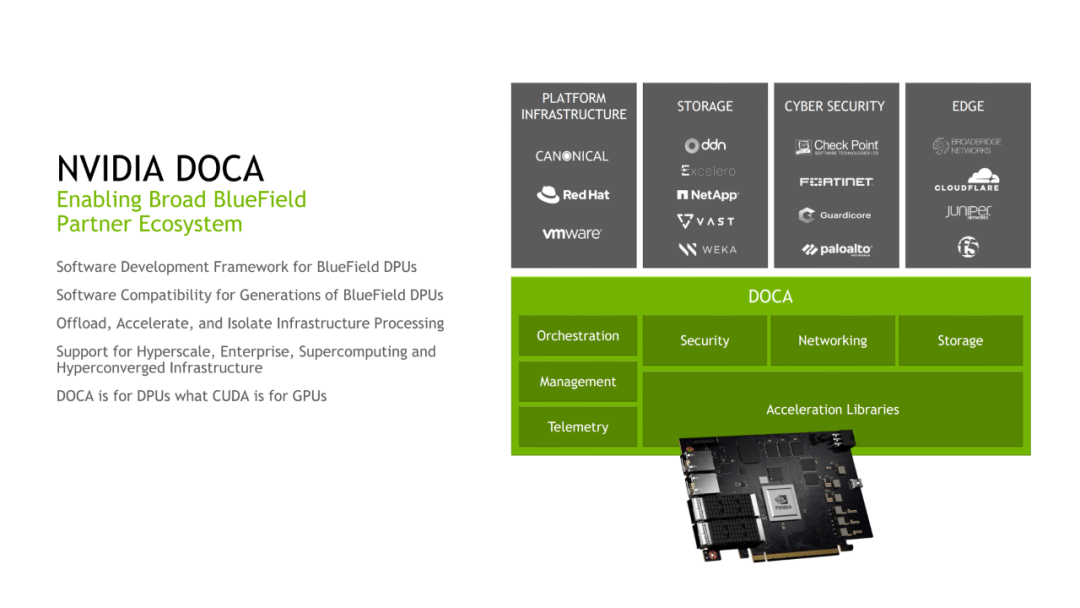

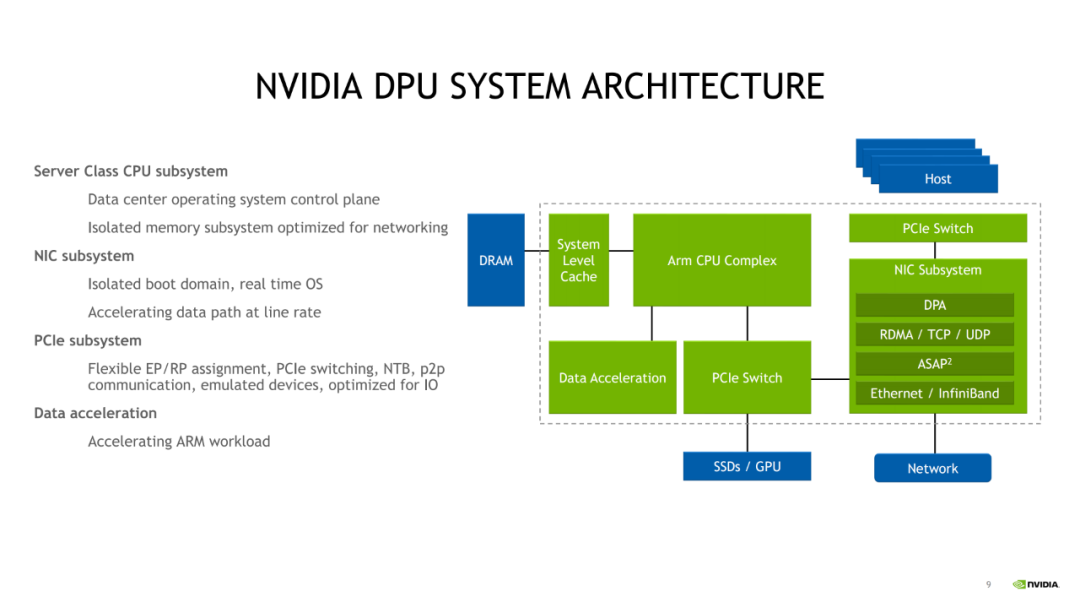

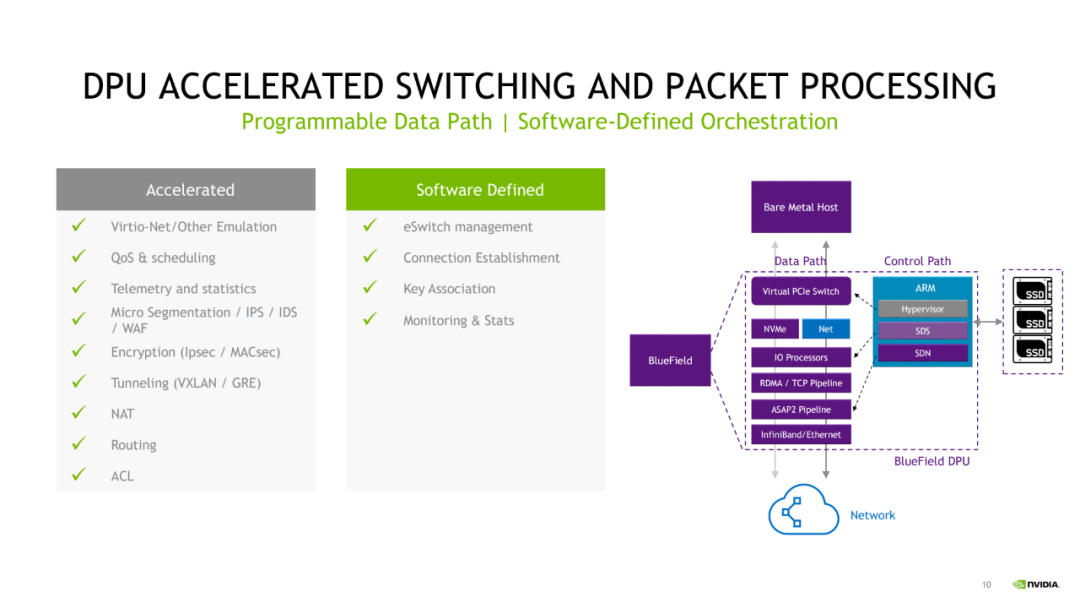

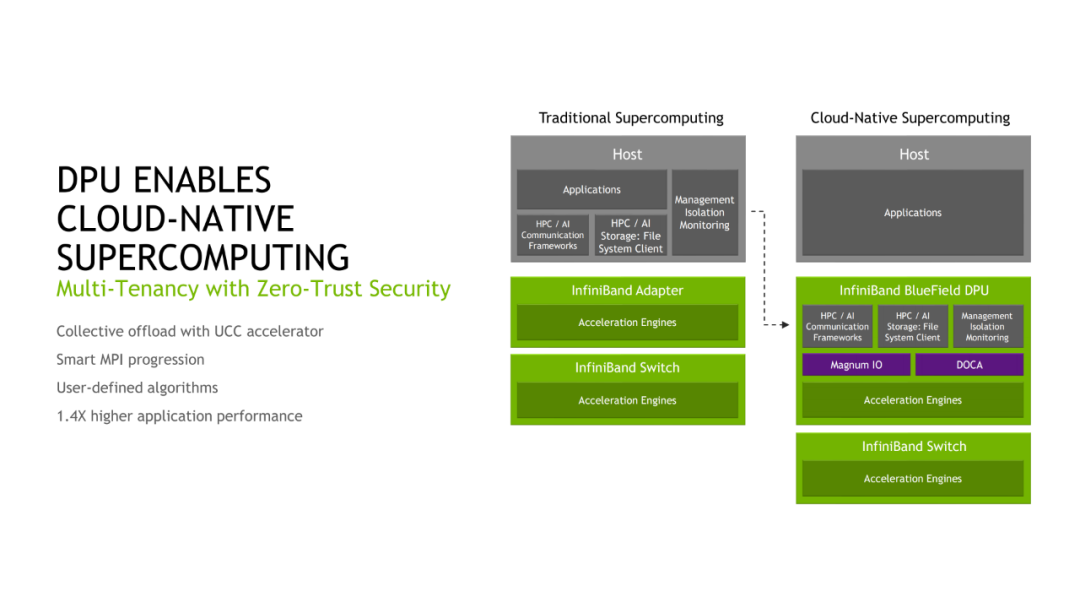

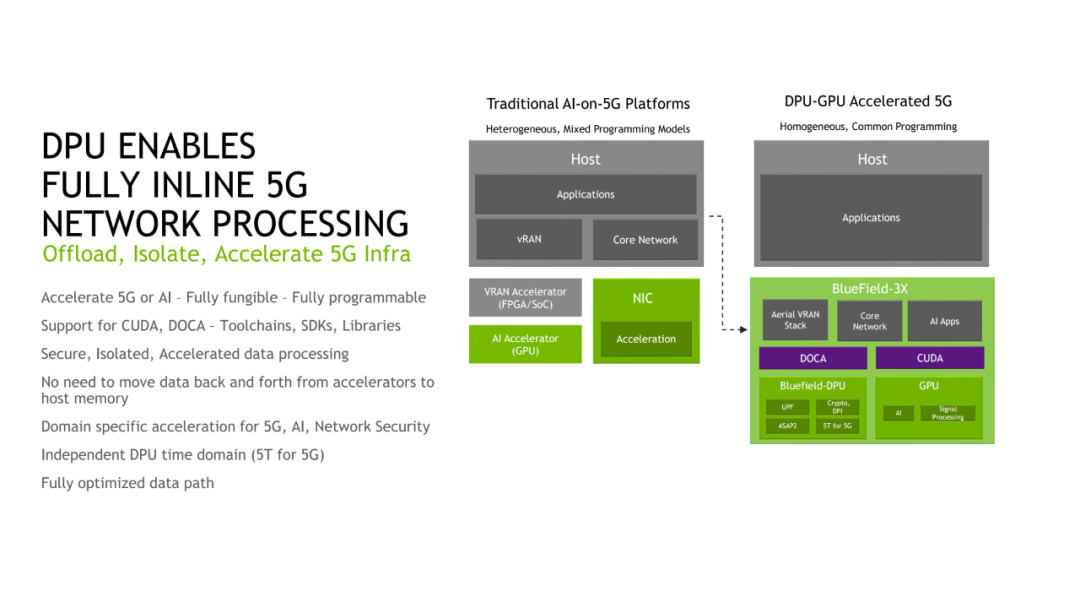

数据处理单元,通常称为DPU,是一种新型可编程的高性能处理器,优化执行和加速由数据中心服务器执行的网络和存储功能。DPU 就像 GPU 一样插在服务器的 PCIe 插槽上,它们允许服务器将网络和存储功能从 CPU 卸载到DPU上 ,从而使 CPU 专注于运行操作系统和系统应用程序。DPU 通常使用可重新编程的 FPGA 与网卡相结合来加速网络流量。

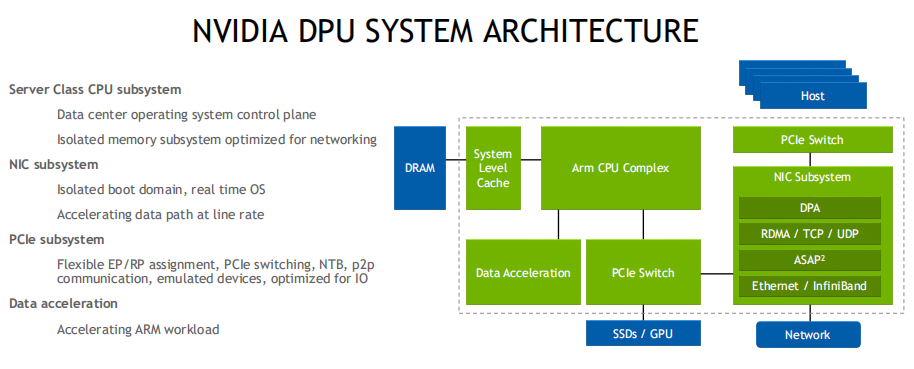

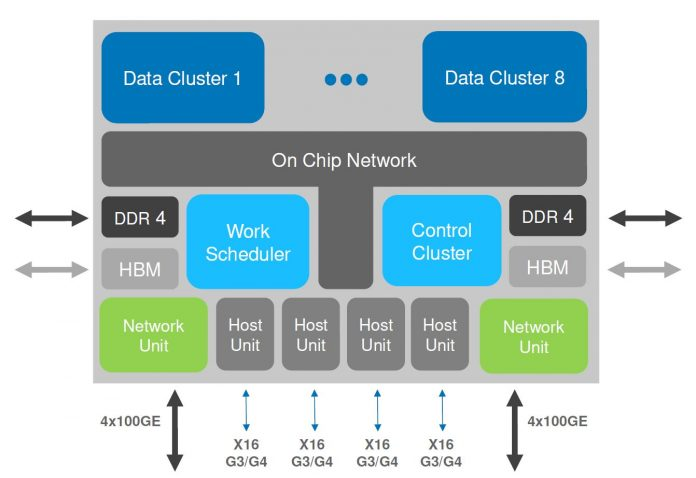

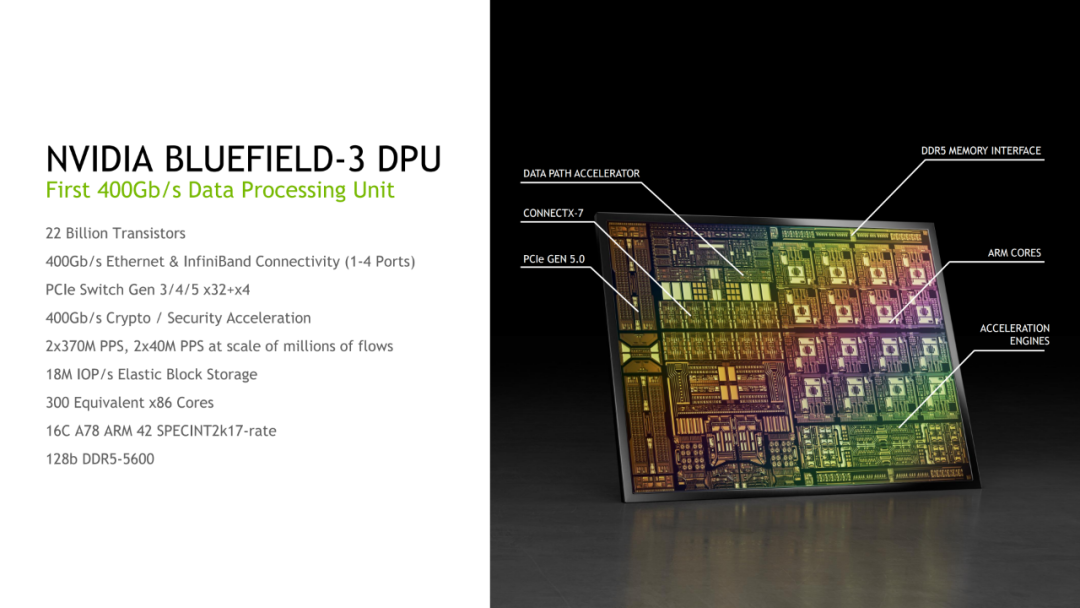

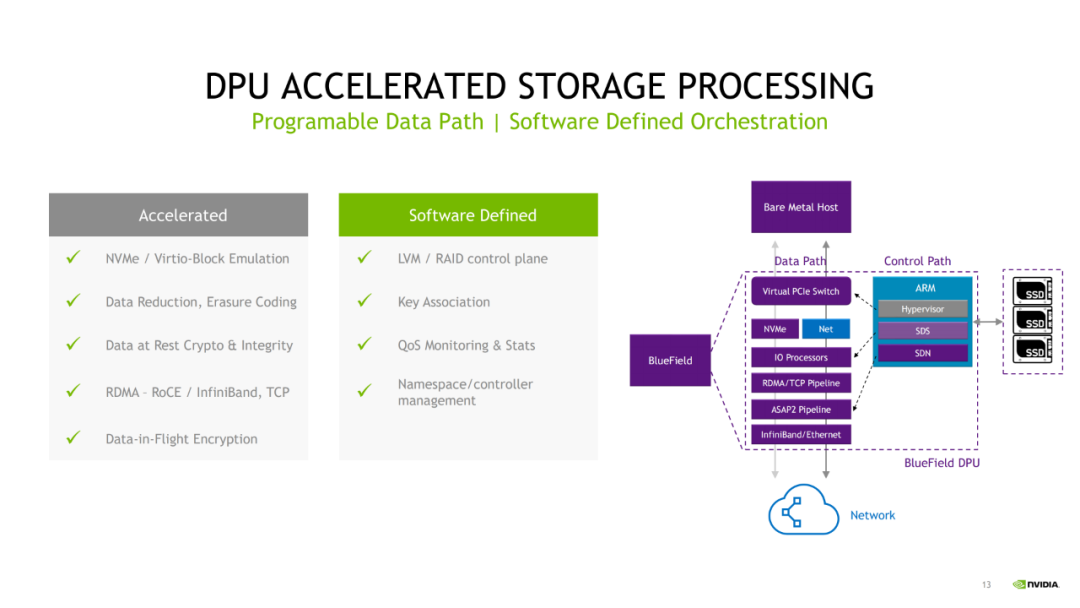

DPU是由三个主要元件组成的片上系统。首先,数据处理单元通常有一个软件可编程的多核 CPU 。第二个元件是高性能网络接口,它使 DPU 能够解析、处理并在网络中有效地传输数据。第三个元件是一组丰富的灵活、可编程的加速引擎,它将网络和存储功能从 CPU 卸载到 DPU。

此外,DPU 可用于处理包括网络安全、防火墙任务、加密和基础设施管理在内的功能。

DPU 最常见的特性是什么?

DPU 具有很多功能,以下是最常见的功能:

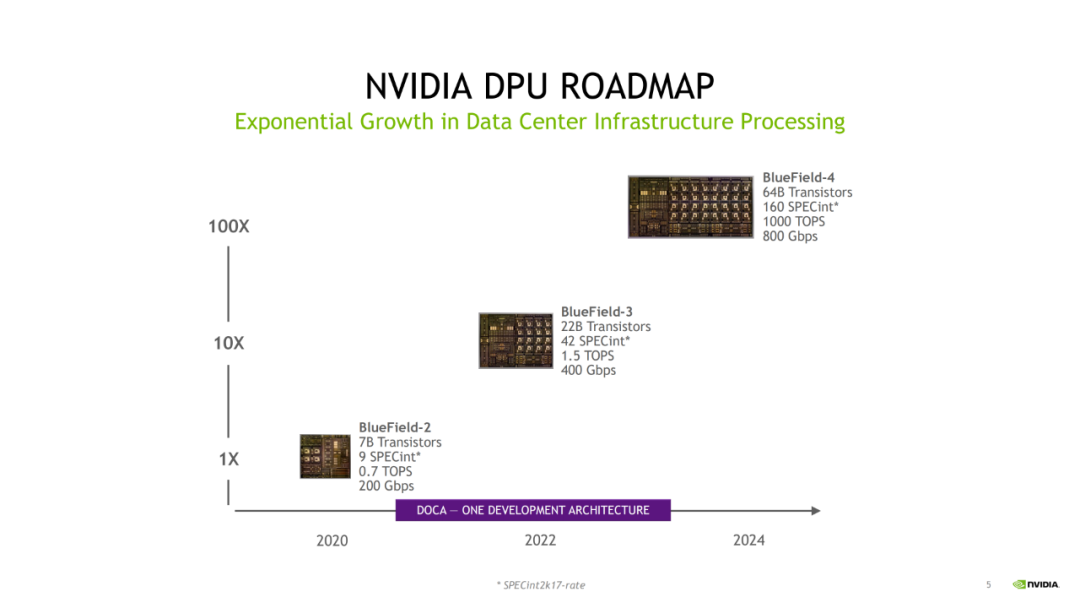

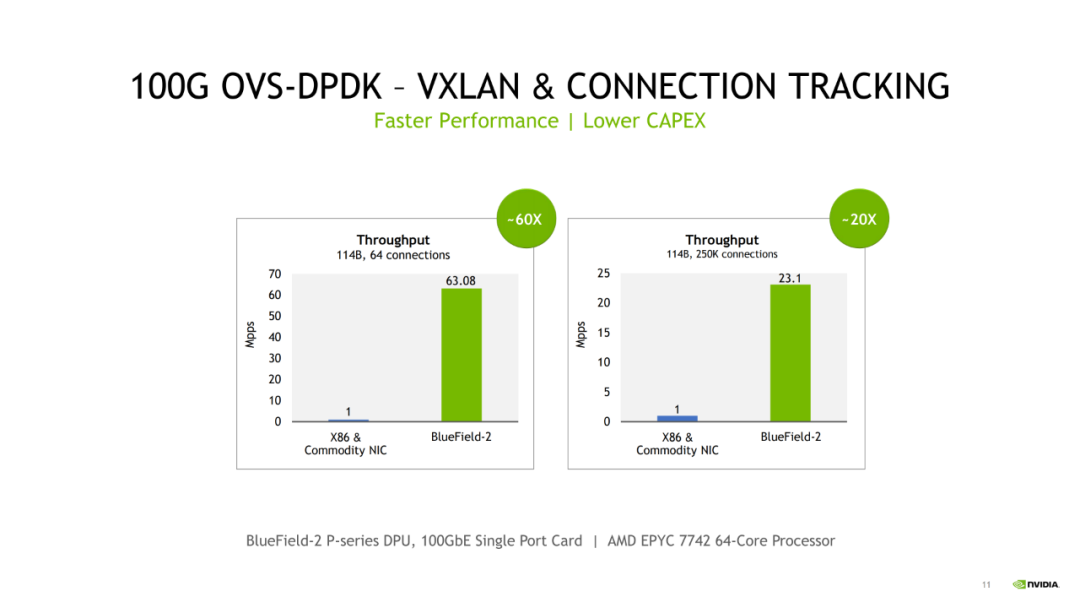

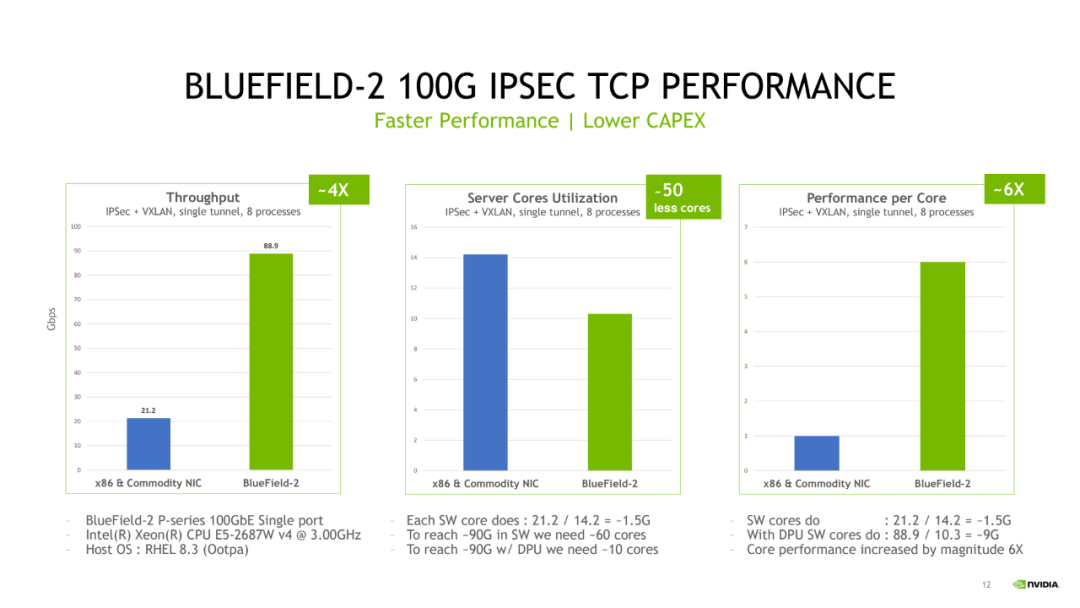

1)通过一个或多个 100 Gigabit 到 200 Gigabit 接口的高速连接

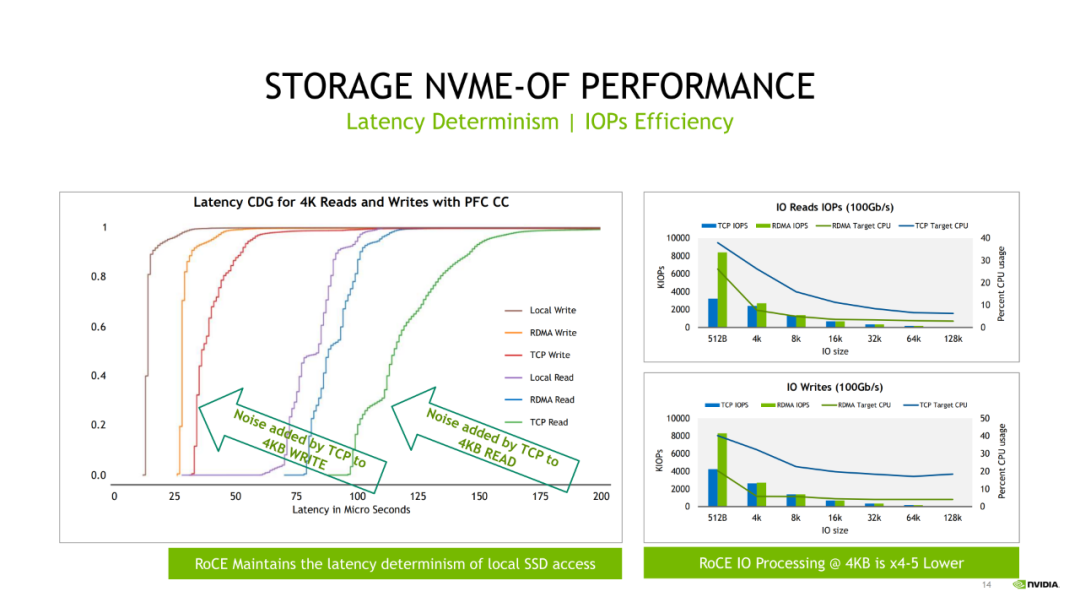

2)高速数据包处理

3)基于 ARM 或 MIPS 的 CPU多核处理处理器(8个64位Arm CPU内核)

4)支持 DDR4和DDR5 RAM的内存控制器

5)加速器

6)PCI Express Gen 4 支持

7)安全功能

8)自定义操作系统与主机系统的操作系统分离

常见的 DPU 解决方案有哪些?

还有哪些其他性能加速器?

本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

电子书<服务器基础知识全解(终极版)>更新完毕,知识点深度讲解,提供182页完整版下载。

获取方式:点击“阅读原文”即可查看PPT可编辑版本和PDF阅读版本详情。

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。