Facebook Feed 流的内存优化实践

点击“开发者技术前线”,选择“星标🔝”

让一部分开发者看到未来

翻译:可可 |英文:https://code.facebook.com/posts/973222319439596

public class HashSet<E> extends AbstractSet<E> implements Set<E>, ... {

transient HashMap<E, HashSet<E>> backingMap;

...

@Override public boolean add(E object) {

return backingMap.put(object, this) == null;

}

@Override public boolean contains(Object object) {

return backingMap.containsKey(object);

}

...

}

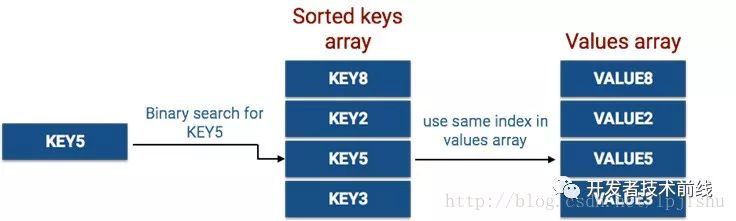

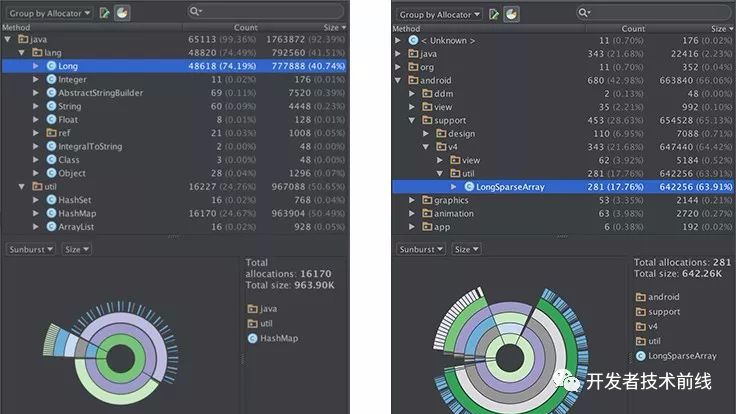

LongSparseArray<String> longSparseArray = new LongSparseArray<>();

longSparseArray.put(3L, "Data");String data = longSparseArray.get(3L); // the value of data is "Data"

选择”开发者技术前线 “星标🔝,内容一触即达。点击原文更多惊喜!

开发者技术前线 汇集技术前线快讯和关注行业趋势,大厂干货,是开发者经历和成长的优秀指南。

历史推荐

点个在看,解锁更多惊喜!

评论