实验室一块GPU都没有!怎么做深度学习?

点击下方“AI算法与图像处理”,一起进步!

重磅干货,第一时间送达

对于很多入门的小伙伴,或者实验室资金并不是非常充足的情况。都会遇到一个问题,想要开始玩一下 深度学习,但是硬件条件非常的短缺,没有GPU,搞个毛线。或者GPU的显存不足,用自己的电脑跑,听着显卡风扇,“呼呼呼”响是真的心痛。

之前写过一些国内外可以白嫖的GPU的平台

白嫖GPU,我们是认真的!(点击即可跳转)

今天分享一下知乎一些过来人的经验

来源:https://www.zhihu.com/question/299434830

编辑:AI算法与图像处理,本文仅供学习交流分享,如有侵权,请连续删文

嗨咯卡特

https://www.zhihu.com/question/299434830/answer/1677664738

作为一个穷学生实验室也是缺GPU,现在来分享一下我最近整理的国内外比较靠谱的解决方案。

国内产品

矩池云

矩池云是我们实验室正在用的,也是使用当中服务体验非常好的一家。为什么会选这家的原因是因为他们家有很优惠的教育折扣。我们老师购买后给我们分发的时长卡。教育折扣算下来应该是全网最低了。

mistGPU

在知乎上口碑不错的一家。

OpenBayes

知道这家是因为在超神经上下数据集的时候发现的,前端非常好看。

百度AI studio

百度AI studio有免费的使用时长,网上有教程怎么装别的框架,不过难度越来越大了。但是属于国内产品中Google Colab一样的存在。所以放最后压轴。

国外产品

Google Colab

Google Colab真的是宇宙良心了。

FloydHub

FloydHub据说很不错,但是之前出现过用国内信用卡买不了的情况。

Paperspace

Paperspace也是一家非常不错的供应商。

Vast

Vast在国外几家里面价格优势最强的。

总结一下,如果是个人用户坚守那家便宜用那家,那家服务好用那家。如果是实验室和老师个人建议可以联系一下矩池云看看矩池云对教育的扶持还是蛮大的。

张航

https://www.zhihu.com/question/299434830/answer/1693216384

这个问题,5年前我也想问。

还记得 CVPR 2015 开完会回来,感觉大家都在讨论 deep learning,convolutional neural network,当时觉得应该试试。我就用网上开源的 LetNet 在笔记本上训练了一下我们当时自己采集的数据集,结果完爆我们费尽心思手动设计的传统方法。我当时就鼓动我老板,让她给实验室买个带 GPU 的机器。结果她语重心长地说: "你看实验室这些旧电脑,我之前给每一个 PhD 学生都配一台电脑,结果没过多长时间,大家都不用了,只用自己的笔记本,所以不要把钱花在硬件上"。我竟无言以对。。。

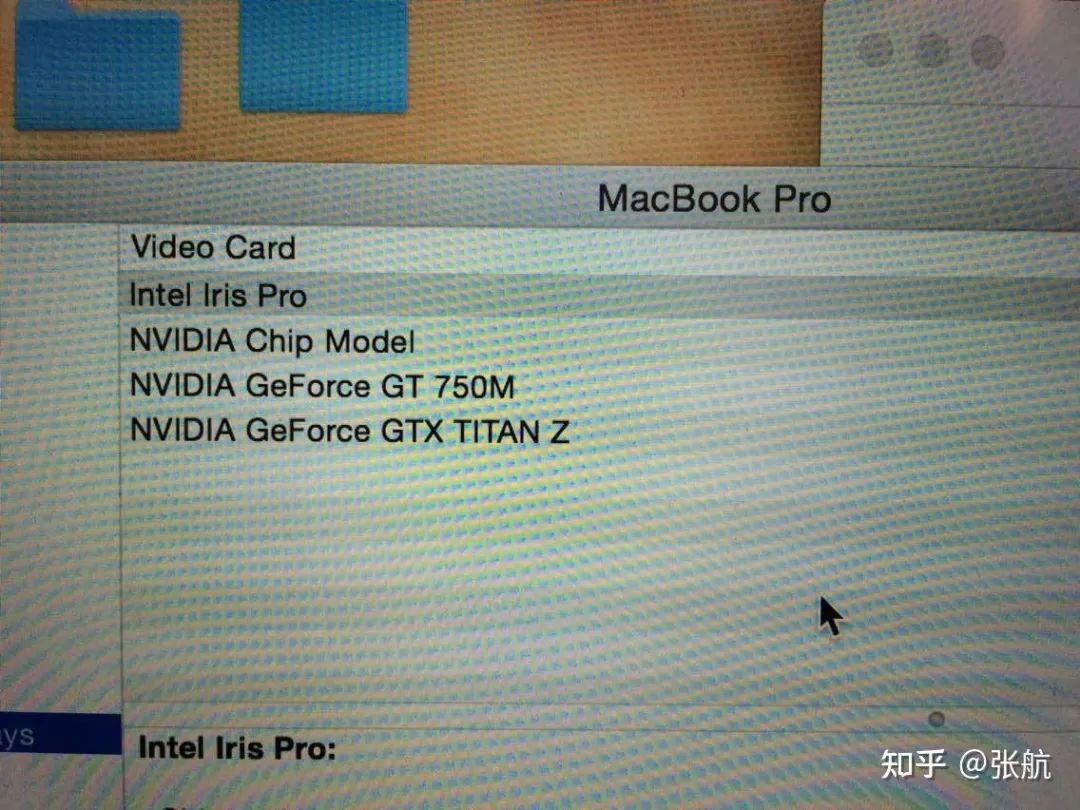

但是 Research 还是要做,我就一狠心买了个 Titan-Z GPU,大概花了博士一个月的工资,然后就有了下面这张图:

那时候还没有 eGPU,我就自己搞了个解决方案,用一个外置台式机电源带动 thunderbolt to PCIe 的转接器。有了这些“装备”之后,我就开始了调参的不归路。

比较早入坑,16 年用 MatConvNet 复现了一下 ResNet zhanghang1989/ResNet-Matconvnet,然后用 ResNet 提了下 feature,比较容易水 paper。在 NVIDIA 实习的时候,听说可以自己写 proposal 向 NVIDIA 申请免费的 GPU,之后就每年都申请一块,直到毕业 (链接:GPU Grant Application)。在发了几篇 deep learning 的 paper 之后,我老板也开始换方向了,而且给组里的学弟们买了8卡的GPU Server(当时是我毕业前帮老板挑的机器,可惜自己没有用到)。

很难想象,当初如果自己没有自费买 GPU,现在我会在哪里,在做什么。如果客观条件不好,尽量想办法克服一下,机会要好好把握

目楽

https://www.zhihu.com/question/299434830/answer/1329278982

Google colab应该是非常不错的选择,长期免费,褥资本主义羊毛,我们绝不手软2333,下面是一个非常简单的三步上手使用教程

首先是介绍(甚至可以跳过):

它的配置大概是15g硬盘(Google drive的云空间)当然各种库文件是不算在内的,你可以把它理解成一个数据存储空间,内存大概是12gb左右,gpu目前有4种,p100,T4,P4,K80,内置tensorflow以及pytorch的完整库文件,如果想用其他深度学习库,一个pip就可以搞定,基本可以满足大部分项目或者比赛的使用体验。

比如之前参加的,情绪识别比赛,数据集大概是10w条文本,使用bert之类的超大预训练模型,也能保证正常运算,不至于内存外存溢出,显存也是8gb-16gb不等

对于colab使用其实只需三个步骤就可以轻松上手:

使用前的必备条件:

一个可以上Google的工具,这里的工具一般有按时间计费还有按流量计费(当然也有各种免费的)我推荐用流量计费的工具比较划算。

Google账号,这个有手机有上一个工具就行。

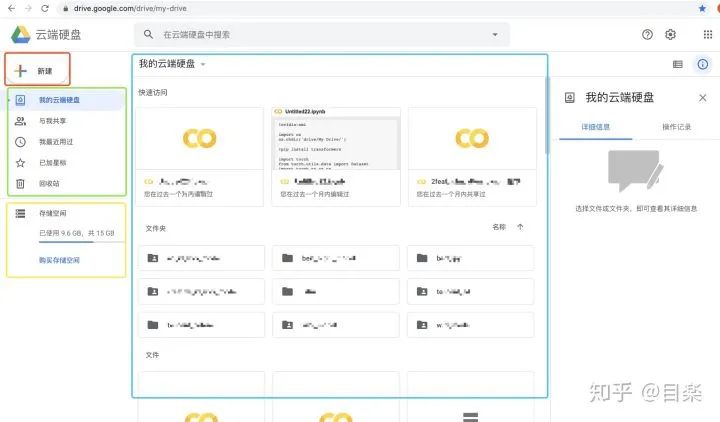

1. 创建一个colab文件

https://drive.google.com/drive/my-drive

进入Google云盘后

如上图所示,红框是新建文件(比如colab文件)绿框是对已有文件,共享文件之类的查看,黄框是储存空间显示,蓝框是存储空间文件可视化。

在使用上,点击之前图里的新建,然后点击更多,再点击colab就可以新建文件了,当然如果是第一次使用,可能存在colab选项不显示的情况,点击关联更多应用即可。

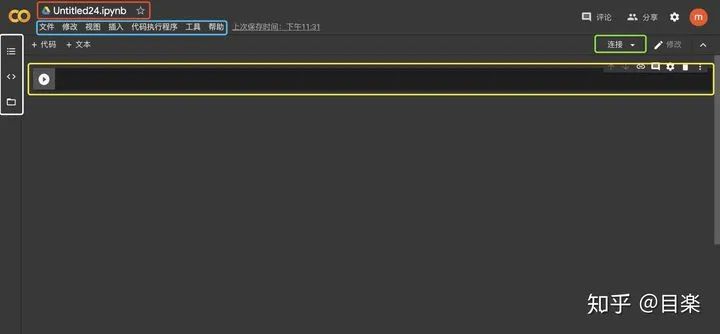

点击colab选项后会跳转到该页面,它与jupyter基本一模一样,黄框是输入代码段,绿框是连接服务器,白框是文件目录,红框是colab文件名,蓝框是使用选项。

2. 配置colab环境(无需任何代码)

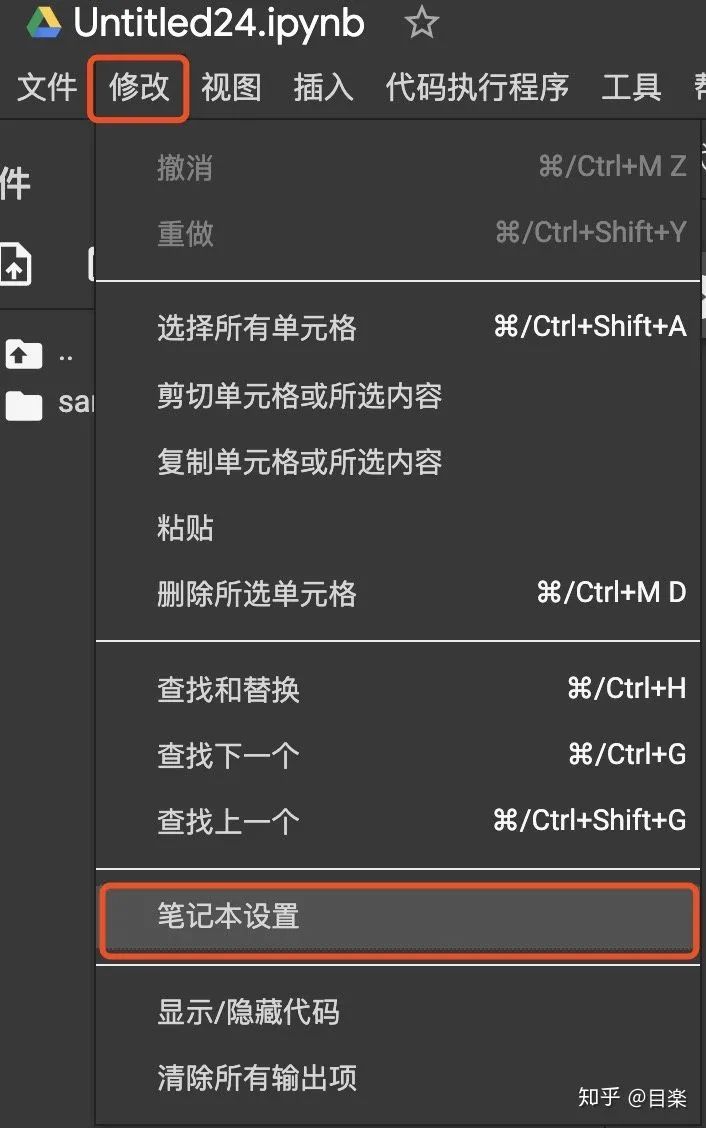

使用第一步,选择gpu,点击前一张图蓝框里的修改,再点击笔记本设置就可以配置gpu了。

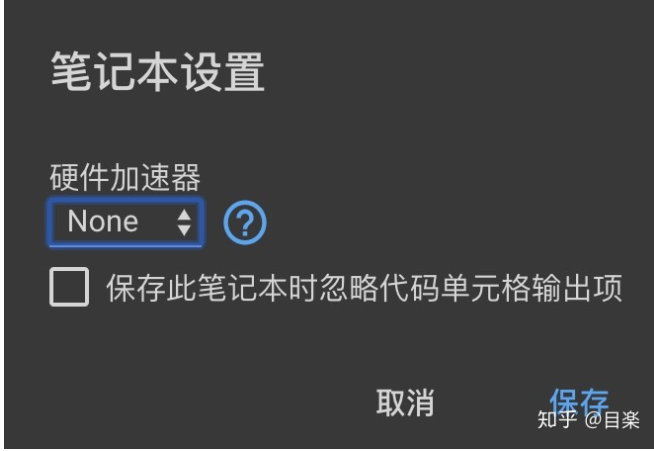

蓝框点击选择gpu即可

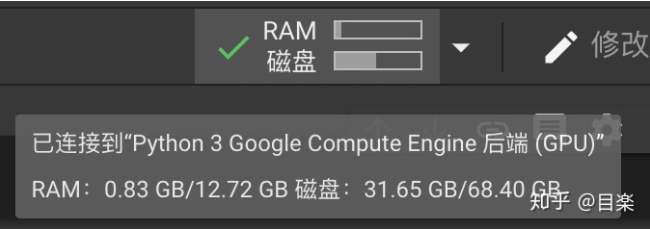

然后点之前绿框的连接即配置好环境

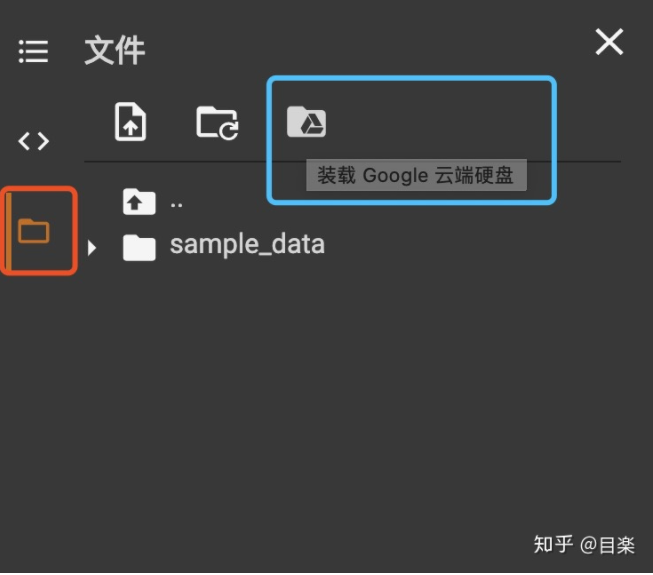

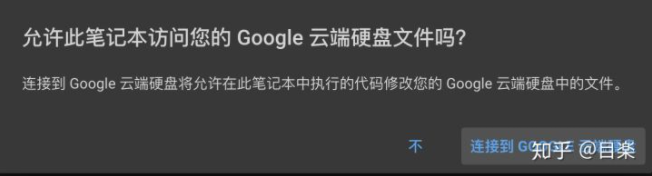

点击图中红框,再点击蓝框即可将Google drive的云空间连接起来

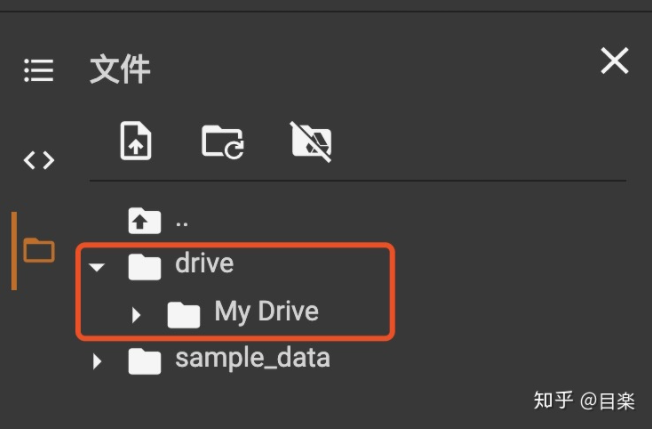

这时就有了drive文件夹

现在配置已经全部完成

3. 简单的上手与配置

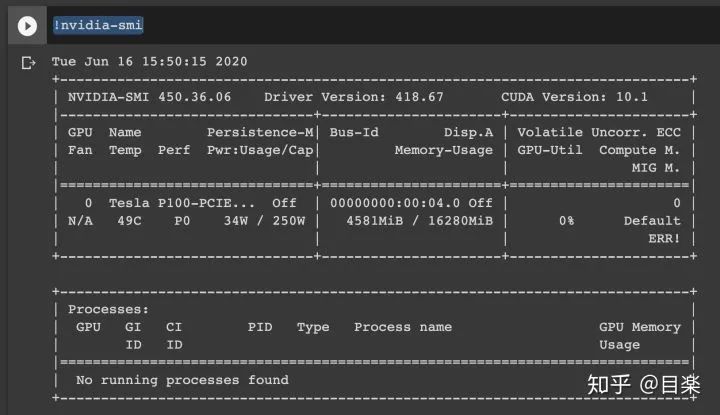

既然已经配置完了,那么就上手使用一下吧,看看我们配置的gpu会是哪一个

很幸运是P100,拥有16g显存,这块卡京东大概3w RMB。

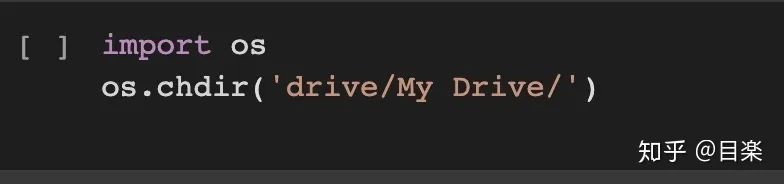

这句其实就是把根目录定位到drive下,这样你的文件和你在Google drive页显示的是相同目录

4. 后记

一些要点:

如果不知道该写一个什么样的项目,下面这篇文章是一篇关于nlp当中情绪识别分类项目的实战,代码已放到github上,包括lstm,bert,xlnet等多种分类模型的使用。(路过别忘了点个赞,github加个star吧)

https://blog.csdn.net/weixin_43823140/article/details/106891612

https://github.com/SuperpeakZhou/emotion_reg

2. 对于colab使用的一些窍门:

如果gpu不是p100而是k80,两者计算速度还是有明显差距的,可以选择再新建一个colab文件,一般两三次就可以开到p100了。

如果Google drive的云空间不够了,建议不要买,因为真的很贵,你可以选择更明智的方式,再弄一个Google账号2333,因为drive互相分享文件是非常便捷的,且分享文件是不占据当前用户存储空间。

如果gpu资源用尽,基本上如果你天天使用10小时以上colab,可能就会面临只能用cpu,gpu用完的场景,需要1天时间恢复,解决方案和上面一样,再弄一个谷歌账号。

努力分享优质的计算机视觉相关内容,欢迎关注:

个人微信(如果没有备注不拉群!) 请注明:地区+学校/企业+研究方向+昵称

下载1:何恺明顶会分享

在「AI算法与图像处理」公众号后台回复:何恺明,即可下载。总共有6份PDF,涉及 ResNet、Mask RCNN等经典工作的总结分析

下载2:终身受益的编程指南:Google编程风格指南

在「AI算法与图像处理」公众号后台回复:c++,即可下载。历经十年考验,最权威的编程规范!

下载3 CVPR2021 在「AI算法与图像处理」公众号后台回复:CVPR,即可下载1467篇CVPR 2020论文 和 CVPR 2021 最新论文

点亮  只需一秒,我却能开心一天

只需一秒,我却能开心一天