基于各种机器学习和深度学习的中文微博情感分析

来源:机器学习AI算法工程 本文约600字,建议阅读5分钟

本文中,我们介绍了中文微博情感分析的情况。

中文微博情感分类语料库

"情感分析"是我本科的毕业设计,也是我入门并爱上NLP的项目hhh,当时网上相关语料库的质量都太低了,索性就自己写了个爬虫,一边标注一边爬,现在就把它发出来供大家交流。因为是自己的项目,所以标注是相当认真的,还请了朋友帮忙校验,过滤掉了广告/太短/太长/表意不明等语料,语料质量是绝对可以保证的。 带情感标注的微博语料数量: 10000(train.txt)+500(test.txt)

数据格式

文档的每一行代表一条语料。 每条语料的第一个数据为微博对应的mid,是每条微博的唯一标签,可以通过"https://m.weibo.cn/status/" + mid 访问到该条微博的网页(部分微博可能已被博主删除)。 第二个数据为情感标签,0表示负面,1表示正面。

项目说明

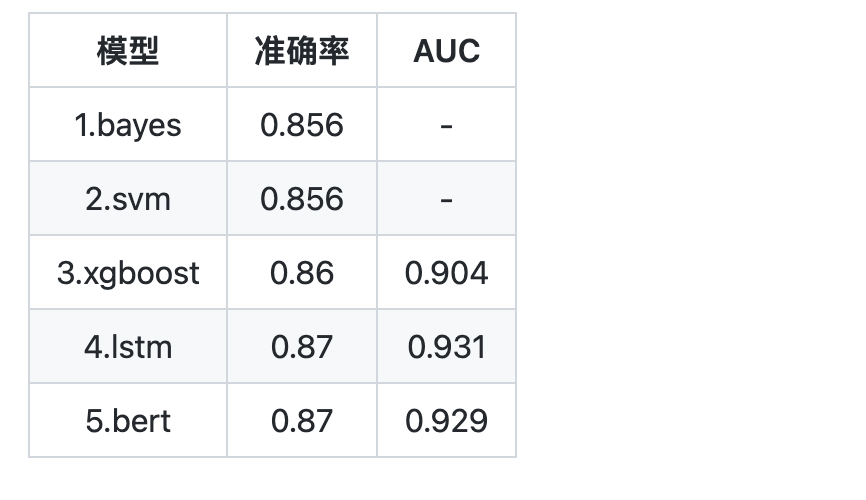

训练集10000条语料,测试集500条语料。 使用朴素贝叶斯、SVM、XGBoost、LSTM和Bert,等多种模型搭建并训练二分类模型。 前3个模型都采用端到端的训练方法。 LSTM先预训练得到Word2Vec词向量,在训练神经网络。 Bert使用的是哈工大的预训练模型,用Bert的[CLS]位输出在一个下游网络上进行finetune。预训练模型需要自行下载。

实验结果

项目资料:

基于情感词典、k-NN、Bayes、最大熵、SVM的情感分析

https://github.com/chaoming0625/SentimentPolarityAnalysis

风险事件文本分类(达观杯Rank4)

https://github.com/DA-southampton/DaguanFengxian

编辑:王菁

校对:林亦霖

评论