磁盘 IO 真的比网络 IO 快吗?

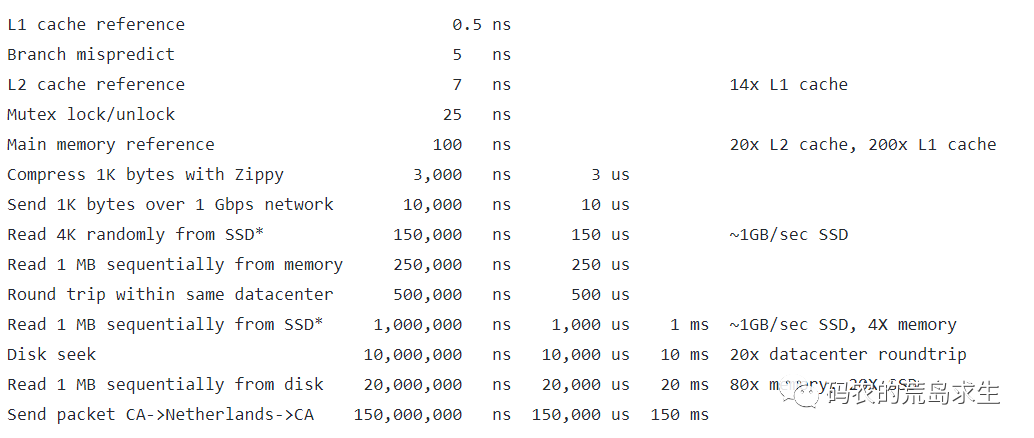

Google大神 Jeff Dean在之前的一次演讲中展示了这样一张表,非常有意思:

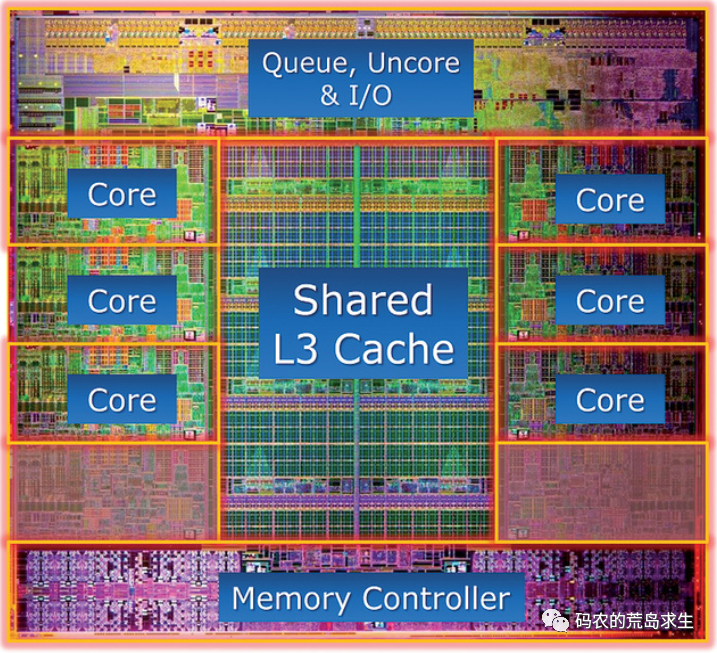

访存与cache

访问L2 cache的时延大概是访问L1 cache的10几倍左右,而访问一次内存的时延则高达访问L2 cache的20倍,是访问L1cache耗时的200倍。这一部分清楚的告诉每个程序员,编写出对cache友好的程序是至关重要的,尤其你的场景如果对性能要求很高则更是如此。

分支预测

该功能主要针对 if 语句,由于现代CPU内部采用流水线方式来处理机器指令,因此在 if 对应的机器指令还没有执行完时后续指令就要进到流水线中,此时CPU就必须猜测到底 if 语句是否为真,如果CPU猜对了,那么流水线照常运行,但如果猜错了流水线中已经被执行的一部分指令就要作废。

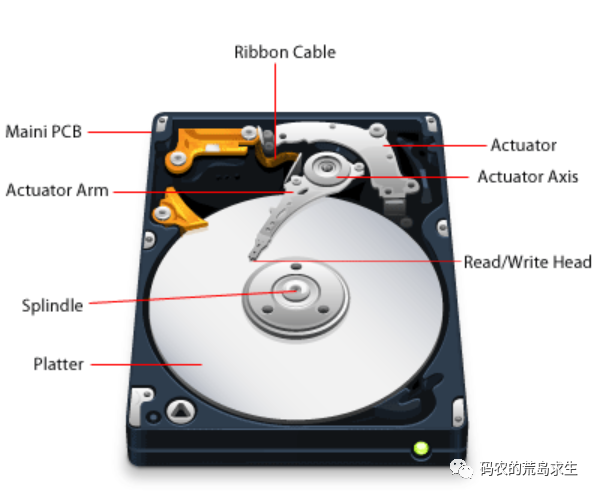

内存、SSD与磁盘

程序员都知道访问内存的速度比SSD块,访问SSD速度比磁盘快,那么到底能快多少呢?同样顺序读取1MB数据,内存花费的时间为250,000 ns,SSD为1,000,000 ns,磁盘为20,000,000 ns。我们可以看到,同样读取1MB数据,磁盘花费的时间是 SSD 的 20 倍,是内存的80倍。

网络与磁盘

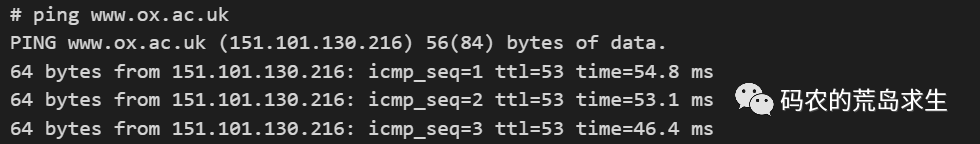

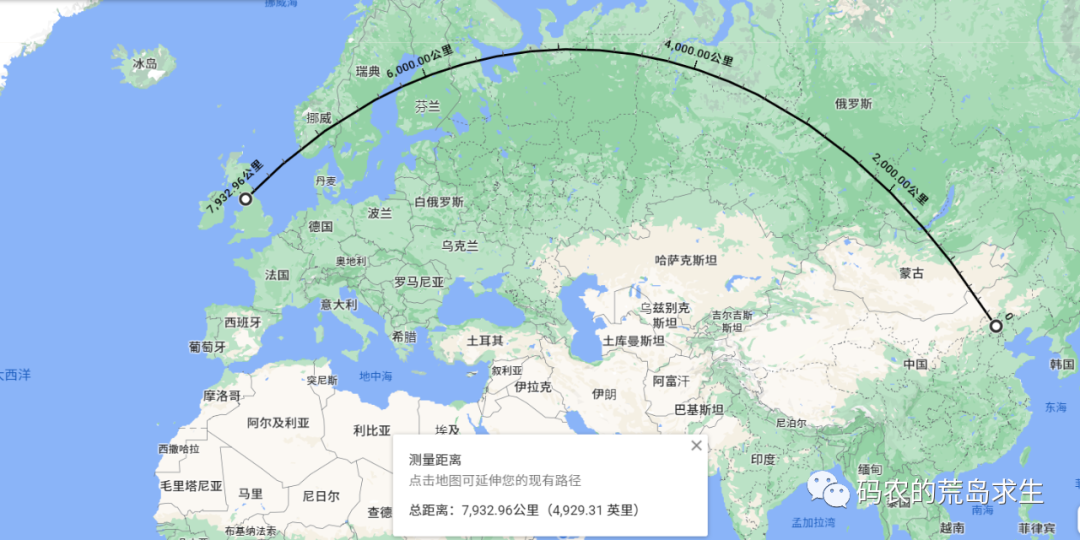

一般来说我们认为内存比磁盘快,磁盘比网络快,但这这张表告诉我们用1Gbps网络发送1K数据仅仅需要20,000 ns,而磁盘的一次寻道则高达10,000,000ns(10ms),网络IO可不一定比磁盘IO慢。当然,这也要看网络两端距离有多远。网络

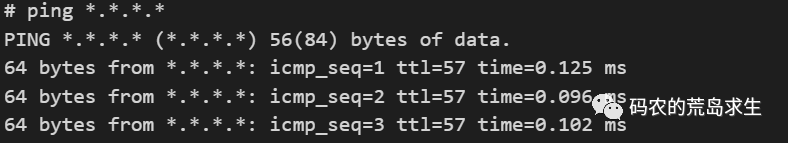

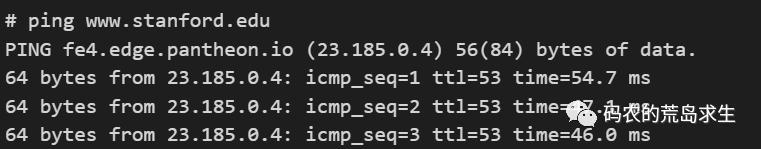

想测量数据包在网络两端来回一趟需要耗时多少?ping命令再简单方便不过了。首先,博主在数据中心内部ping一台主机(注:ip地址用*来代替):

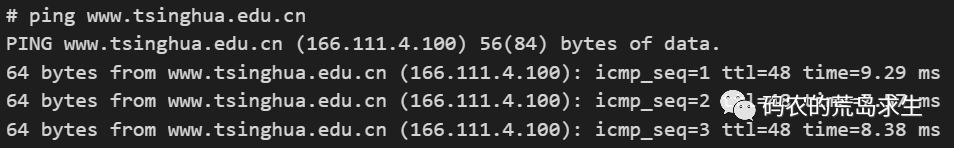

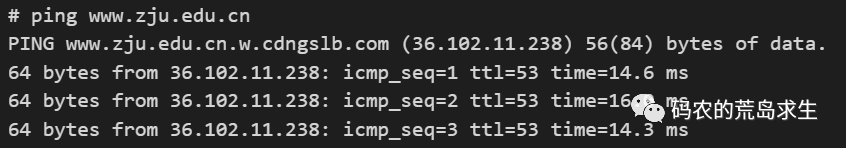

我的坐标在北京,接下来我们ping一下清华大学,哈哈,注意现在由于云服务商的存在,清华大学的官网服务器主机可不一定在清华大学里,为简单起见我们认为所ping的机器都在相应的地理位置上。

总结

系统设计一种工程实践,不是艺术遐想,每一个关键决策都要有依据而不能拍脑袋,本文的这张表就是你的依据(之一)。希望这篇文章对大家理解系统时间有所帮助。

评论