它来了,它来了.ORB_SLAM3走来了

点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

在2015年,Juan D. Tardos等人发布了ORB_SLAM2.

2020年暑假,全新 ORB_SLAM3上线啦!!

哎,学不过来了!

论文地址

https://arxiv.org/abs/2007.11898

代码地址

https://github.com/UZ-SLAMLab/ORB_SLAM3

目前代码还不能在GitHub上搜到,毕竟论文刚刚发表,过几天应该就能搜到了.

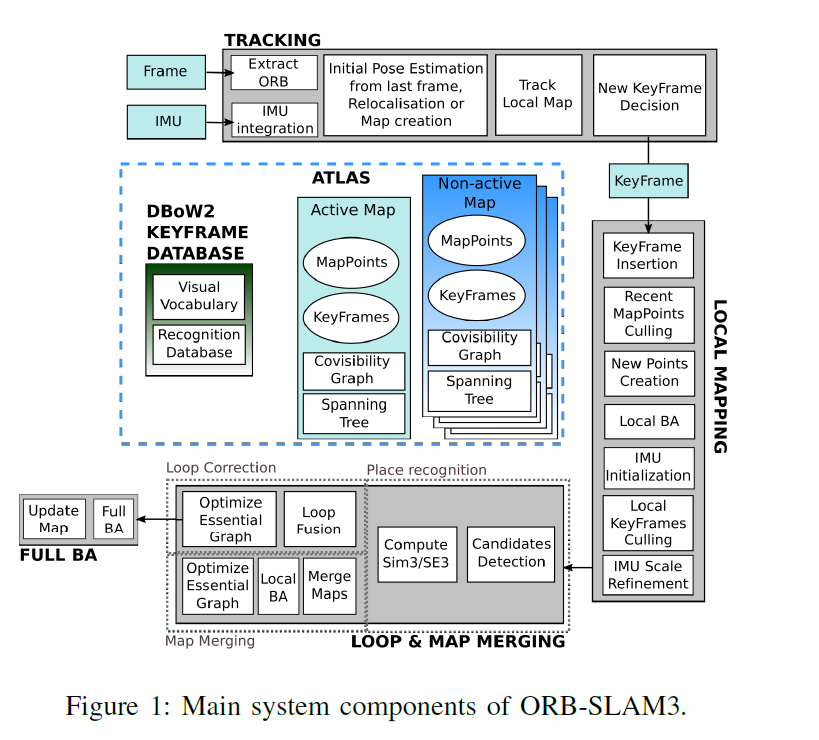

系统组成

数据集测试

官方给了六个视频,这里分享一下

概要

本文介绍了ORB-SLAM3,这是第一个能够用单目、立体和RGB-D相机,使用针孔和鱼眼镜头模型进行视觉、视觉惯性和多地图SLAM的系统.

第一个主要的创新是一个基于特征的紧密集成视觉惯性SLAM系统,它完全依赖于最大后验概率MAP估计,甚至在IMU初始化阶段也是如此.其在小型和大型,室内和室外环境中都能稳定地运行,并且比以前的方法精确2到5倍.

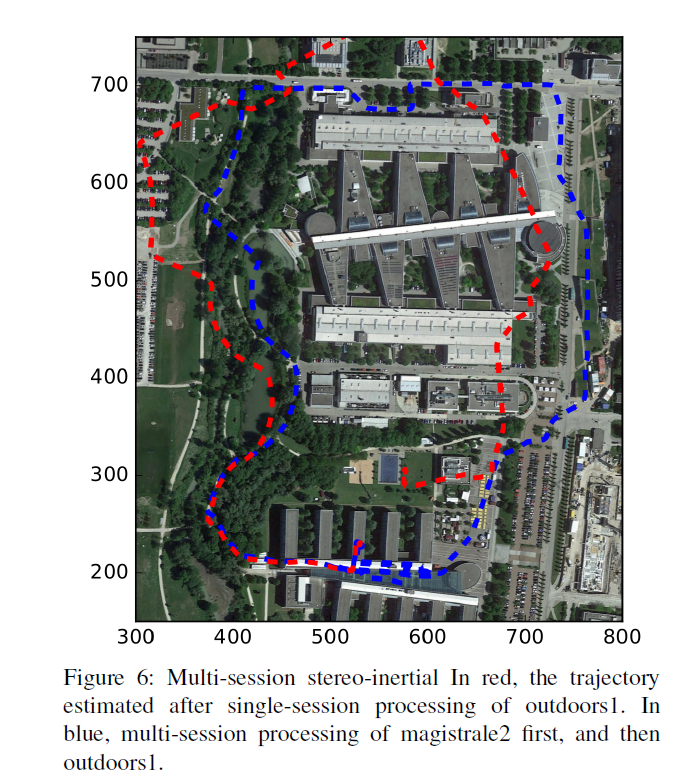

第二个主要的创新是一个多地图系统(multi-map),它依赖于一种新的位置识别方法和改进的召回,多亏了它,ORB_SLAM3能够在长时间的恶劣视觉信息下生存;当它丢失时,它会启动一个新的地图,当重新访问地图区域时,它将与以前的地图无缝地合并.

与只使用最后几秒信息的视觉里程计系统相比,ORB_SLAM3是第一个能够在所有算法阶段重用所有先验信息的系统.这允许包含BA调整共视关键帧,这些关键帧提供了高视差观测,提高了精度.

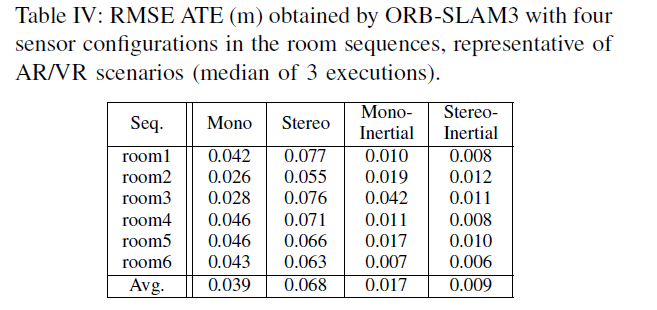

我们的实验表明,在所有的传感器配置中,ORB_SLAM3与文献中可用的最佳系统一样鲁棒,并且更精确.值得注意的是,我们的立体惯性SLAM在EuRoC无人机上的平均精度为3.6cm,在TUM-VI数据集(AR/VR场景的一个典型设置)中,快速手持移动时的平均精度为9mm,最后,我们开源了代码.

实验结果

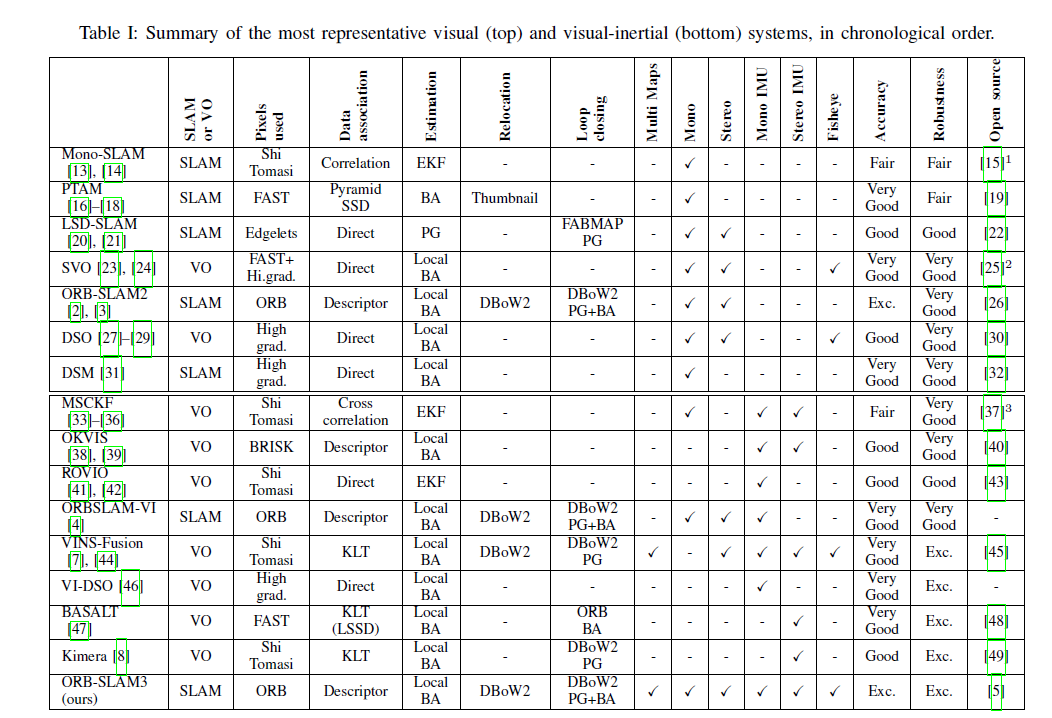

按时间顺序总结的最具代表性的视觉和视觉惯性系统

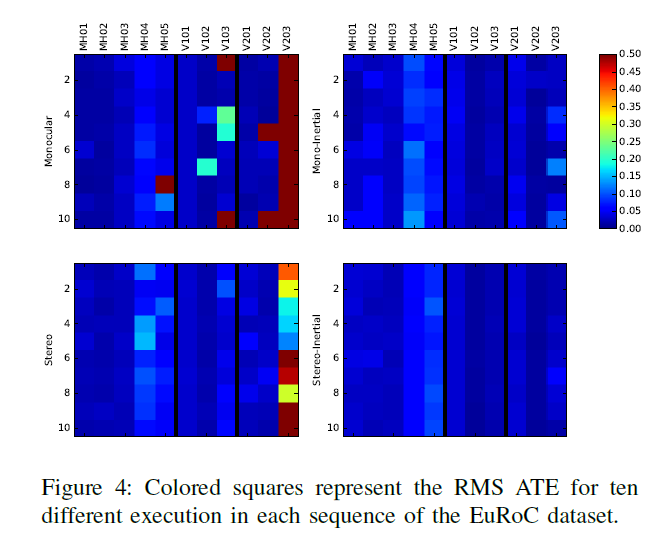

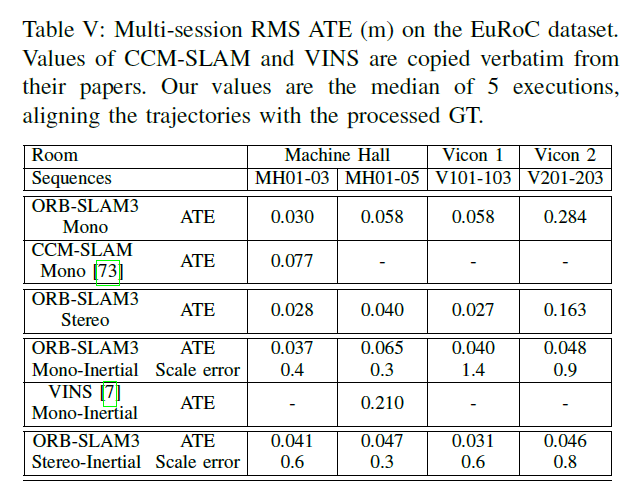

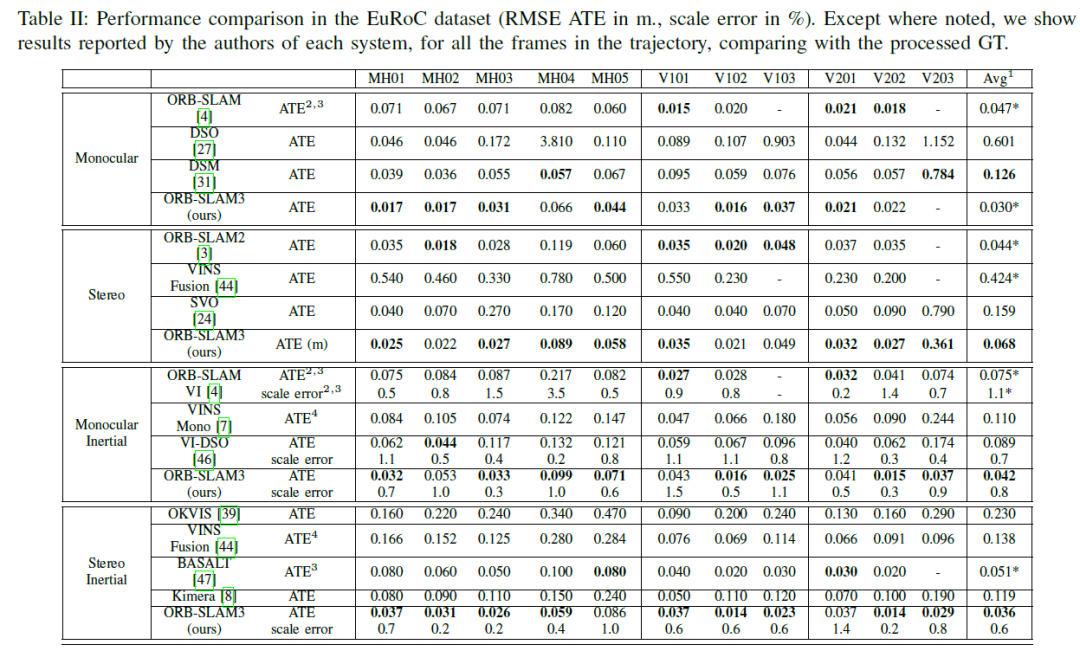

下图为EuRoC数据集的性能比较:

除特别说明外,我们展示了每个系统的作者报告的结果,对轨迹中的所有帧与处理后的GT进行比较.

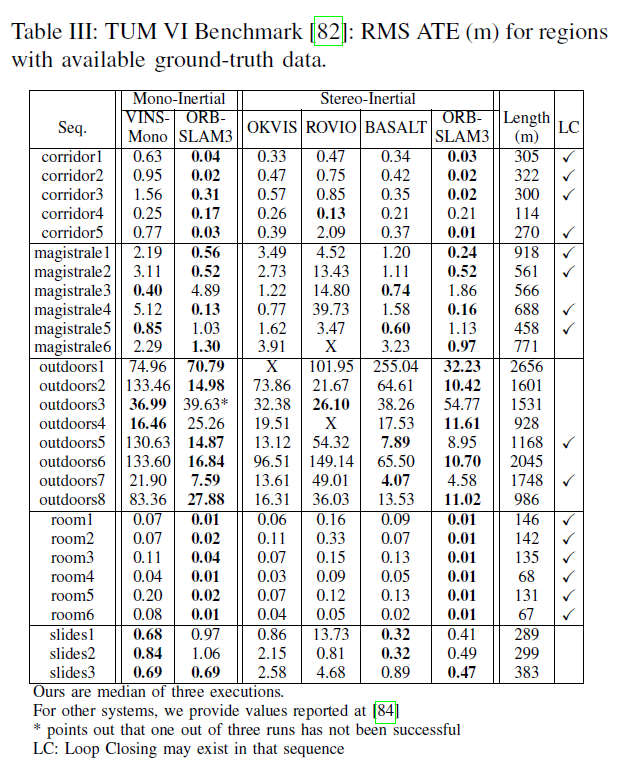

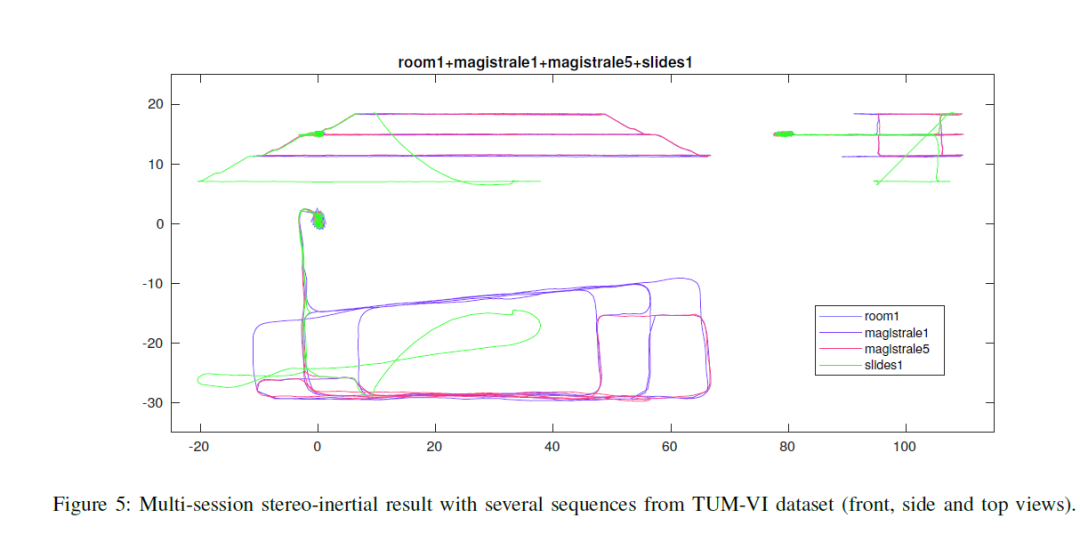

其他结果