更精准地生成字幕!哥大&Facebook开发AI新框架,多模态融合,性能更强

子豪 发自 凹非寺

量子位 报道 | 公众号 QbitAI

现在,给视频添加字幕,又有了新玩法。

这就是Facebook、哥伦比亚大学等大学的新研究,共同开发了一个框架——Vx2Text。

这个框架可以帮助我们,从视频、音频等输入内容中提取信息,再以人类可以理解的文字,生成字幕或者回答问题等。

并且,与之前的最新技术相比,Vx2Text在三个任务中均展现出最佳的性能。

Vx2Text究竟是什么?一起往下看。

技术原理

Vx2Text是从多模态输入(由视频、文本、语音或音频组成)中提取信息,再以人类可以理解的方式,生成自然语言文本(例如:字幕、回答问题等)。

研究团队通过引入大型基准,来评估Vx2Text解释信息和生成自然语言的能力。

这些基准主要包括:用于图像或视频字幕、问答(QA)和视听对话的数据集。

为了在这些基准测试中表现出色,Vx2Text必须完成几个目标:

从每个模态中提取重要信息;

有效地组合不同线索,以解决给定的问题;

以可理解的文本形式,将结果生成和呈现出来。

并且,将这些目标嵌入一个统一的、端到端的可训练的框架中。

整个过程可以分为三步:

多模态输入及识别; 将不同模态嵌入同一语言空间; 融合多模态信息。

△Vx2Text框架图解

具体而言:

输入及识别

Vx2Text接收视频、音频和语音作为输入。利用特定模态分类器,来识别输入的声音或动作等,得到相应类别的文本信息。

嵌入

通过可区分标记化,将识别得到的不同模态的文本信息,嵌入同一语言空间中,以便执行多模态融合,实现端到端的训练。

多模态融合,简单来说就是,将从文本、图像、语音、视频等多种形式的数据和信息,进行转换和融合。

先前不同模态输入信号的组合方法,大多依赖于额外的跨模态融合模块,繁重且计算成本高。

而使用Vx2Text,无需设计专门的跨模态网络模块,这种设计不仅简单得多,还可以带来更好的性能。

融合

采用通用的编-解码器语言模型,即自回归解码器模型,来融合多模态信息,以生成文本。

不同于以前的仅编码器模型,这一模型具有通用性,能直接适用于“不同模态生成文本”问题,无缝处理两种类型的任务,无需为每个任务设计专门的架构。

处理生成式任务,需要通过解码生成连贯的句子;

处理区分式任务,则需将候选答案集输入,在概率分布下,选择最高概率的答案。

实验

对Vx2Text在三个任务中的有效性进行评估:包括视频问答、视听场景感知对话和视频字幕。

分别使用三个基准数据集:TVQA、AVSD和TVC。

评估每种模态的重要性

使用不同的输入组合,评估各个模态对基于视频的文本生成性能的影响。结果表明:

在AVSD和TVQA数据集中,每种模态都有助于性能提升,对于AVSD尤其明显。

在AVSD的所有指标下,增加视频模态的都会带来性能提升;TVQA数据集也体现这种趋势。

此外,问答的历史记录对AVSD的性能,也起到十分积极的作用。这表明模型在对话中,成功合并了先前问答的信息。

可区分标记化的的有效性

将不同的模态融合机制(包括:多模态特征嵌入、冻结标记化、可区分标记化),在AVSD和TVQA中的性能进行比较,得到结论:

与多模式特征嵌入相比,冻结标记化实现了更好的性能。

可区分标记化通过优化整个端到端模型,进一步提高了这两项任务的性能,在很大程度上优于其他方案。

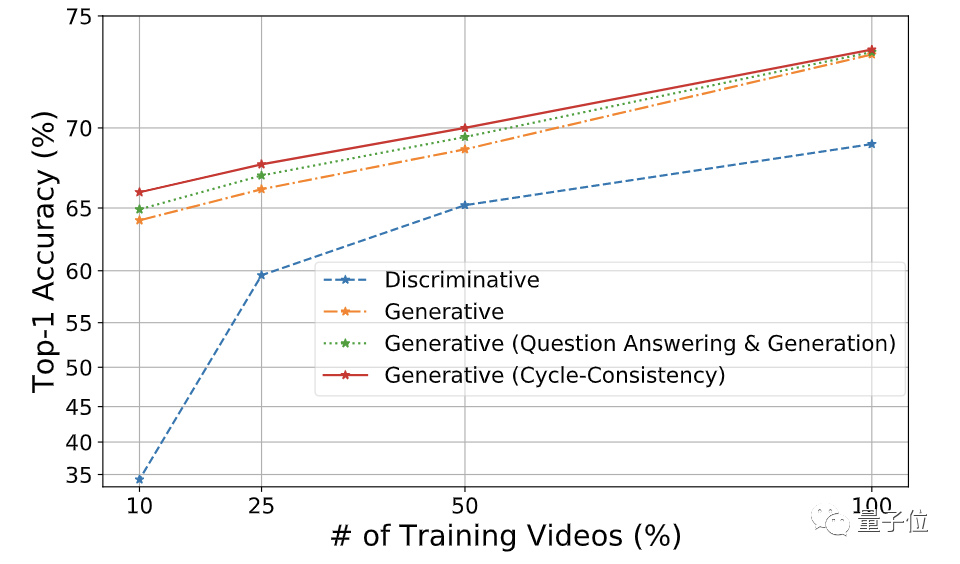

生成模型的优势

对四个模型的准确性进行评估,得到结论:

对于所有大小的训练集,与去掉解码器的系统判别版本(Discriminative)相比,默认的Vx2Text模型(Generative)都更准确。

此外,生成模型可以使用相同的模型进行多任务学习,无需更改架构。这样能够进一步提高准确性,尤其是对于小型训练集。

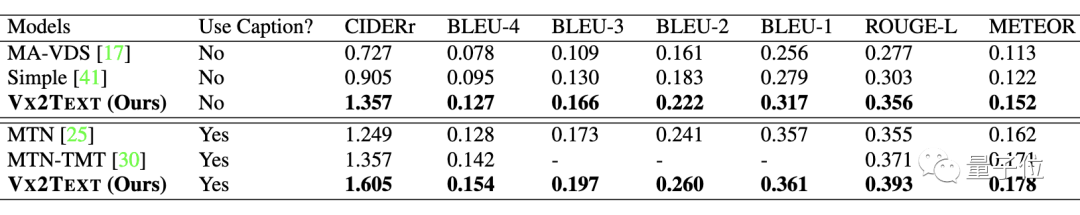

与最新技术的比较

Vx2Text(这里使用冻结标记化,而非可区分标记化)与最新技术,在AVSD上进行比较,得到结论:

在带有和不带有字幕输入两种情况下,Vx2Text模型都取得了最好的效果。证明了这一模态集成简单方案的有效性。

Vx2Text与最新技术,在TVQA上进行比较(数字代表Top-1准确性(%)),得到结论:

在HERO利用额外的样本进行预训练的情况下,Vx2Text仍然实现了比HERO版本更好的性能。

Vx2Text与最新技术,在TVC上进行对比,得到结论:

在不使用额外样本进行预训练的情况下,Vx2Text展现出最佳的性能。

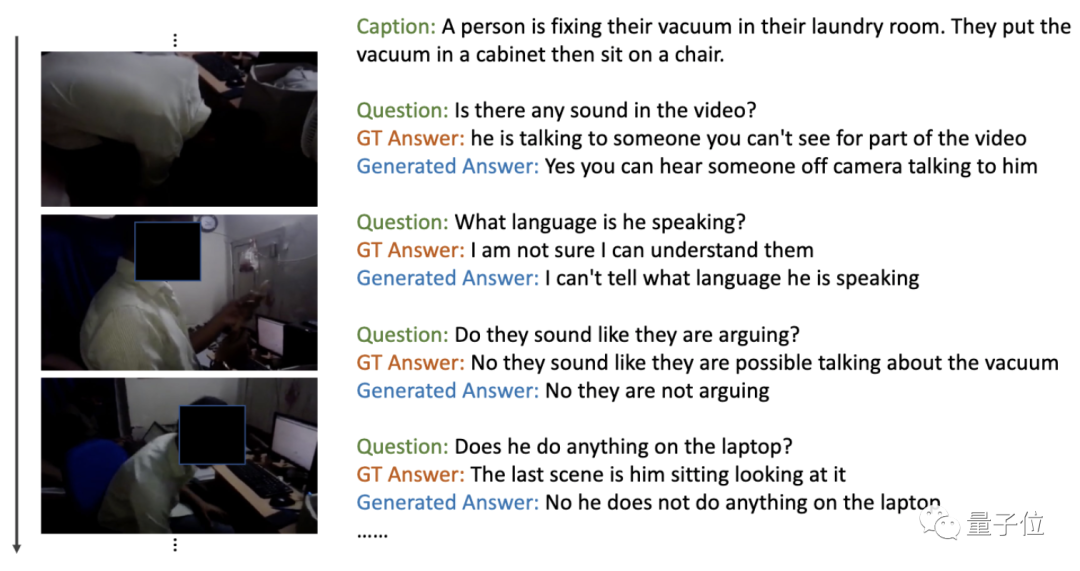

定性结论

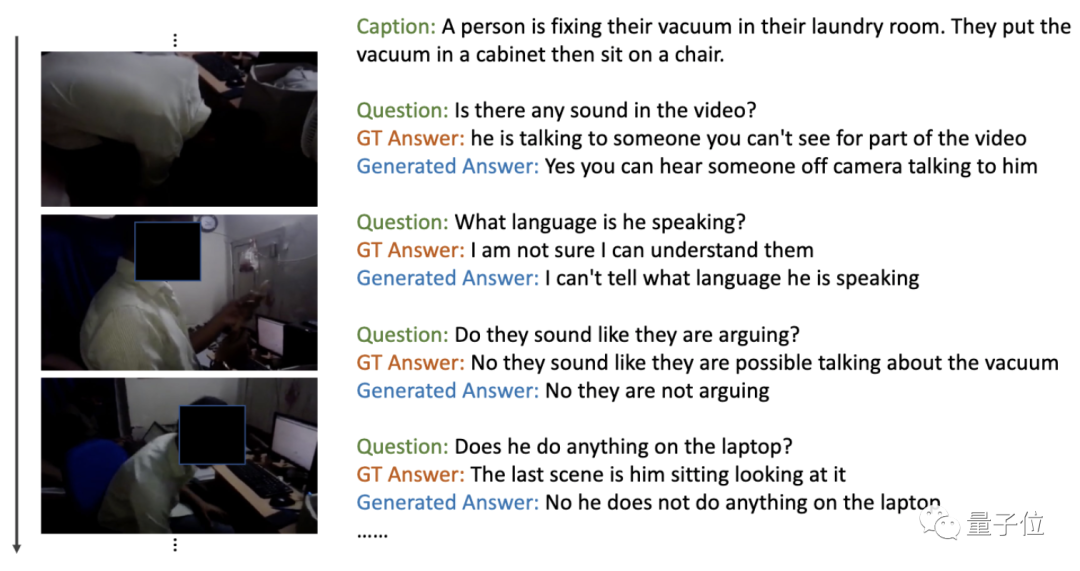

△AVSD验证集上的视听场景感知对话任务,Vx2Text生成答案示例

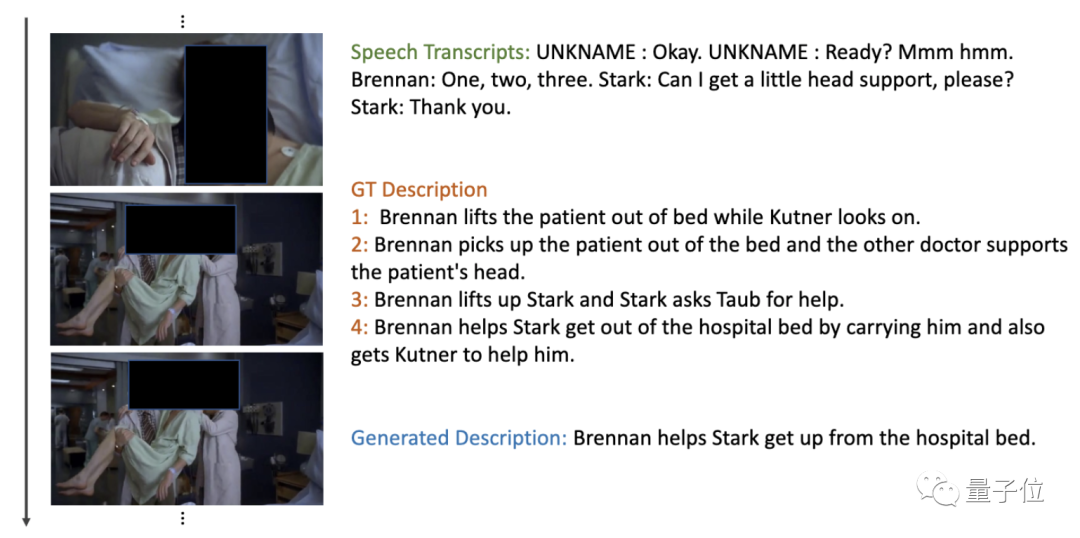

△TVC验证集上的视频字幕任务,Vx2Text生成文本描述示例

虽然输入内容中包含一些文本,例如:对话历史记录或语音记录,但生成的文本还包含了来自其他模态的信息。例如,上图中模型成功地识别了动作,例如,帮助站起来等。

实验表明:Vx2Text能够在多模态输入中,为视听场景感知对话和视频字幕,生成逼真自然的文本。

Vx2Text可以用于为录制的视频或流媒体视频添加字幕,以及服务YouTube和Vimeo等视频共享平台,依靠字幕以及其他信号来改善搜索结果的相关性。

作者

论文一作蔺旭东,目前是哥伦比亚大学计算机科学专业的博士生,主要研究领域是嵌入学习、视频分析和生成模型,本科就读于清华大学。这项研究是在其担任Facebook AI实习生时完成的。

△蔺旭东(来自其个人主页)

想要了解更多细节,可戳文末链接查看~

参考链接:

https://arxiv.org/abs/2101.12059

https://venturebeat.com/2021/02/02/researchers-Vx2Text-ai-framework-draws-inferences-from-videos-audio-and-text-to-generate-captions/

— 完 —

本文系网易新闻•网易号特色内容激励计划签约账号【量子位】原创内容,未经账号授权,禁止随意转载。

推荐阅读

加入AI社群,拓展你的AI行业人脉

量子位 QbitAI · 头条号签约作者

վ\\'ᴗ\\' ի 追踪AI技术和产品新动态

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见~