DeepMind最新发现!神经网络的性能竟然优于神经符号模型

新智元报道

新智元报道

编辑:keyu

【新智元导读】DeepMind最新的研究结果再一次打破了传统认知——根据研究人员的最新发现,神经网络对数据的要求,居然比神经符号模型还要低!不仅如此,实验结果证实,神经网络的在关键任务上的效果还要更好。不需要预先训练,完全无监督,居然这么神奇?

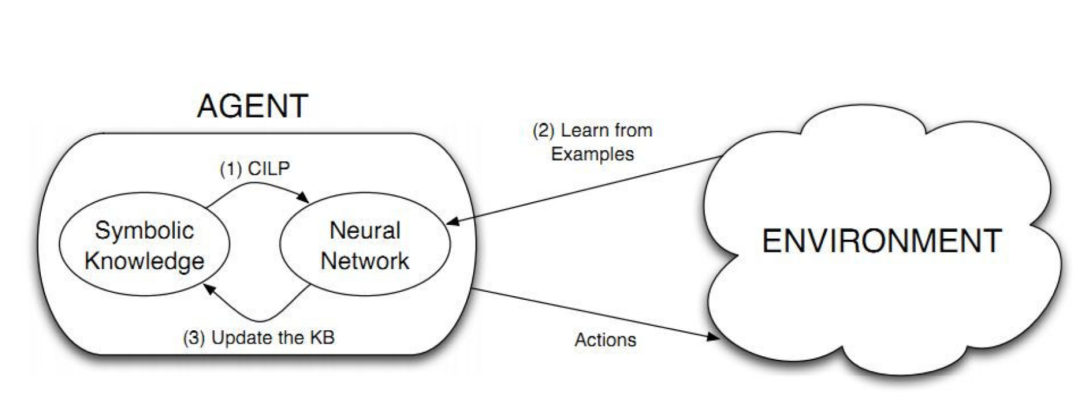

按照之前的常识,结合了算法和符号推理技术的神经符号模型(Neurosymbolic Models),会比神经网络更适合于预测和解释任务,此外,神经符号模型在反事实方面表现更好。

而Neural-Symbolic,本质上其实是将现代数学中的分析学和代数学结合的产物。

分析学擅长处理数值、函数、逼近等问题, 代数学擅长处理推演、抽象、结构等问题,如果能适当将两者结合,会有很可观的效果。

然而,近日,DeepMind的研究人员声称,在正确的测试条件下,神经网络的性能会优于神经符号模型。

与之前的研究结论相反,研究人员认为,对于可以衡量高级认知功能并基于视觉的任务来说,基于分布式表示的神经网络模型确实表现良好,并已经明显胜过了现有的神经符号模型。

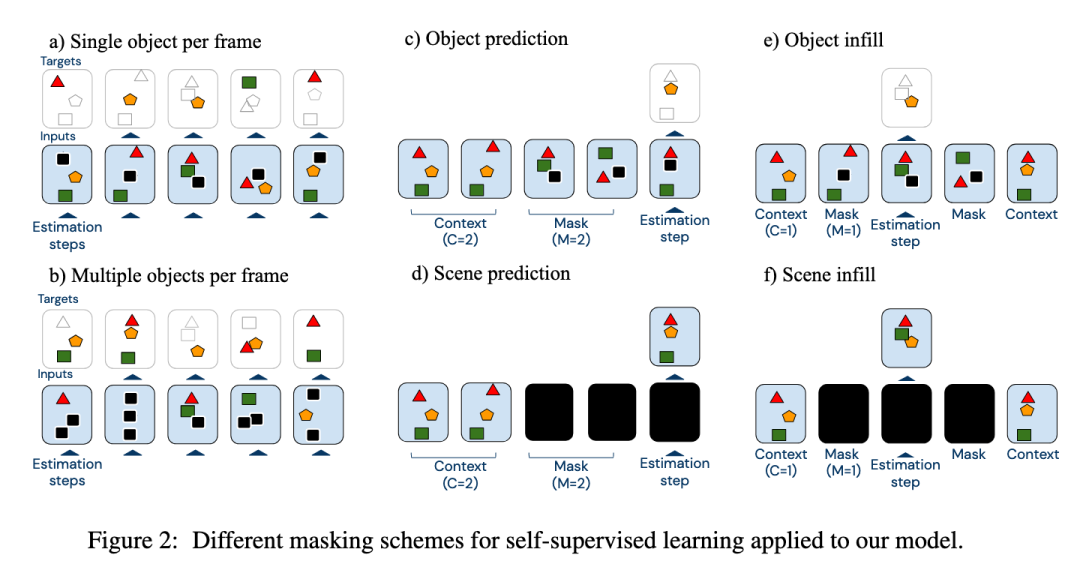

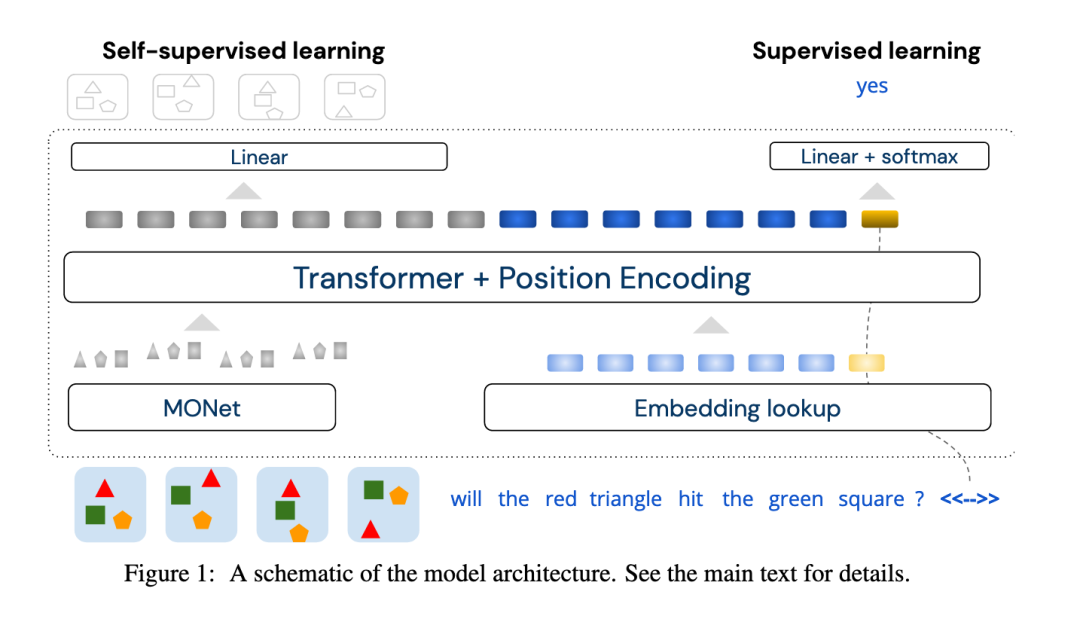

在论文中,作者描述了一种关于视频的时空推理的体系结构,此结构可以学习到视频中的所有成分,并且所有中间的表示都贯穿分布在整个神经网络层中。

论文地址:https://arxiv.org/pdf/2012.08508.pdf

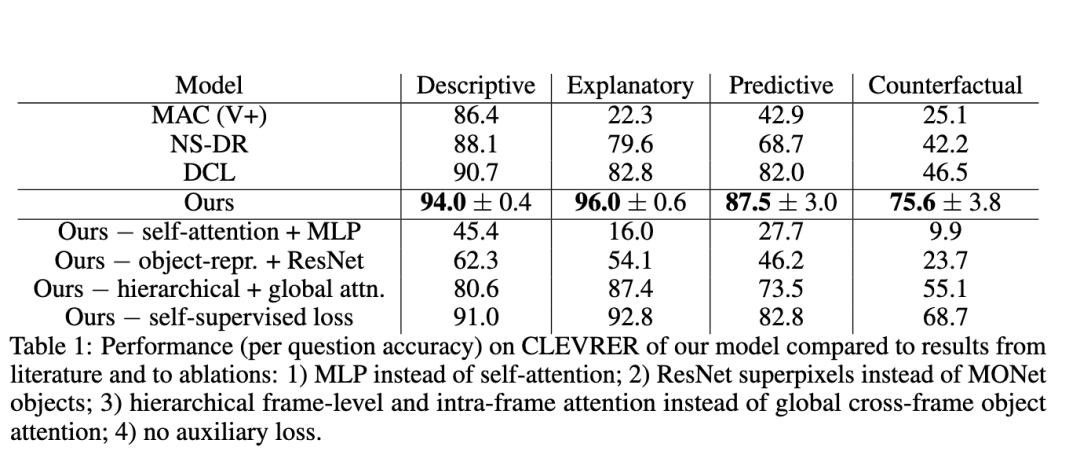

该团队表示,该体系结构在一个流行的数据集上的所有任务的表现,都超过了神经符号模型,并在反事实问题上优势最明显。

这一研究成果,可能会非常有助于设计和开发具有推断作用的机器。

该文章提出的神经网络架构,主要利用注意力机制,来实现对集成信息的高效提取。

有人可能要问了,什么是注意力机制呢?

注意力(attention)其实是一个非常常见,但是又会被忽略的事实。比如天空一只鸟飞过去的时候,往往你的注意力会追随着鸟儿,天空在你的视觉系统中,自然成为了一个背景(background)信息。

计算机视觉中的注意力机制(attention)的基本思想,就是想让系统学会注意力——能够忽略无关信息而关注重点信息。

总的来说,注意力机制就是一种一次只专注于一个元素或几个元素的算法机制。

对于DeepMind这一研究来说,整个训练过程都是自我监督的,这意味着该模型必须使用底层的动态机制,来推断视频中被掩盖的对象,以便提取更多信息。

而且该架构可以确保视频中的视觉元素与物理对象相对应,论文作者认为,这一步骤对于更高层次的推理至关重要。

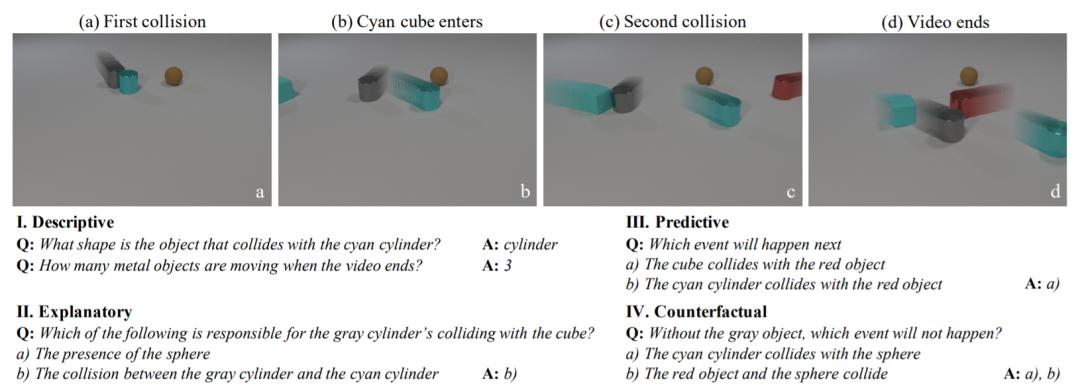

在实验部分,研究人员将他们的神经网络与视频表示和推理的CoLlision事件(也就是CLEVRER数据集)进行了基准比较。

其中,CLEVRER数据集包含由机器生成的20,000多个5秒钟的物体碰撞视频(这几种物体是三种形状,拥有八种颜色的两种材料),以及300,000多个问题和答案。

这些问答都聚焦于逻辑推理的四个要素:描述性(例如,“什么颜色” ),说明性(“造成的原因”),预测性(“接下来会发生什么”)和反事实(“如果某种情况出现,会发生什么”)。

在这里小编附上CLEVRER资源链接:

论文链接:https://arxiv.org/abs/1910.01442

项目链接:http://clevrer.csail.mit.edu/

实验结果表明,在没有预先训练,没有标记数据,且训练数据少40%的情况下,他们的神经网络和最佳神经符号模型性能相当,这无疑挑战了神经网络比神经符号模型更需要数据这一观点。

此外,它在最困难的反事实问题上的得分为59.8%(这一得分比机会模型和所有其他模型都好)。

同时,此模型还可以可以推广到其他任务,包括CATER(旨在预测目标对象在视频最后一帧中的位置的对象跟踪视频数据集)。

研究人员在论文中写道:“我们的研究结果证明了在得益于分布式表示的灵活性和表现力的同时,深层网络可以复制人类认知和推理的许多特性。”

“神经模型在数学上也取得了一些成功,从直觉上讲,该领域需要执行严格的规则,需要操纵各种各样的复杂符号。但是,令人惊讶的是,大型神经语言模型其实并不需要需进行目标任务的明确训练,也可获得算术推理和类推的能力。

这表明,在扩展到更多数据,并使用更大,更高效的体系结构时,当前的神经网络局限性得到了改善。”

参考链接:

https://blog.csdn.net/hanss2/article/details/90345517

https://venturebeat.com/2020/12/21/deepmind-researchers-claim-neural-networks-can-outperform-neurosymbolic-models-on-visual-tasks/

推荐阅读:

「2020中国AI算力报告」重磅出炉:中国怎么解决GPT-3的算力难题?