基于深度学习的特征提取和匹配

转载自 | 计算机视觉life

作者 | 黄浴

链接 | https://zhuanlan.zhihu.com/p/78053406

计算机视觉需要图像预处理,比如特征提取,包括特征点,边缘和轮廓之类。以前做跟踪和3-D重建,首先就得提取特征。特征点以前成功的就是SIFT/SURF/FAST之类,现在完全可以通过CNN模型形成的特征图来定义。

特征提取

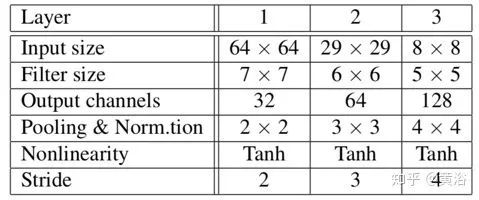

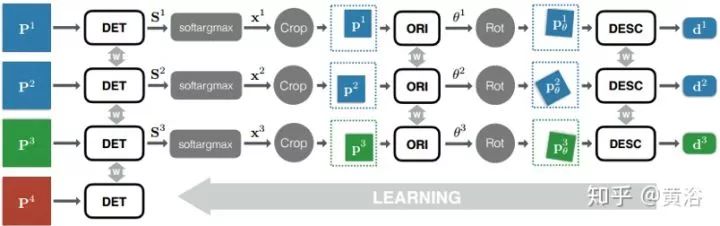

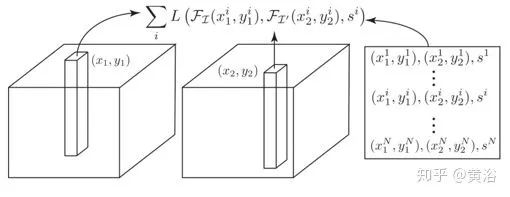

1) 给定输入图像块P,检测器提供得分图S; 2) 在得分图S上执行soft argmax 并返回单个潜在特征点位置x。 3) 用空间变换器层裁剪(Spatial Transformer layer Crop)提取一个以x为中心的较小的补丁p(如图5-3), 作为朝向估计器的输入。 4) 朝向估计器预测补丁方向θ。 5) 根据该方向第二个空间变换器层(图中的Rot)旋转p产生pθ。 6) pθ送到描述子网络计算特征向量d。

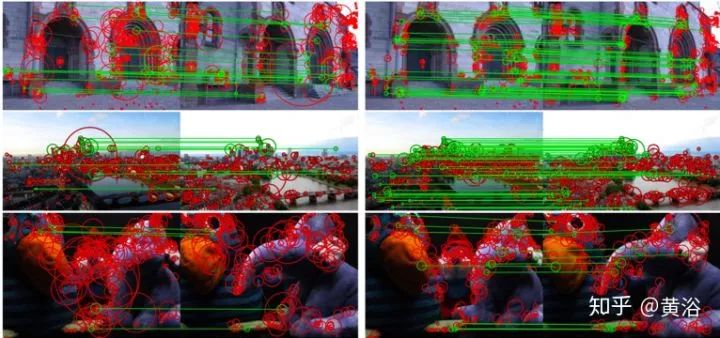

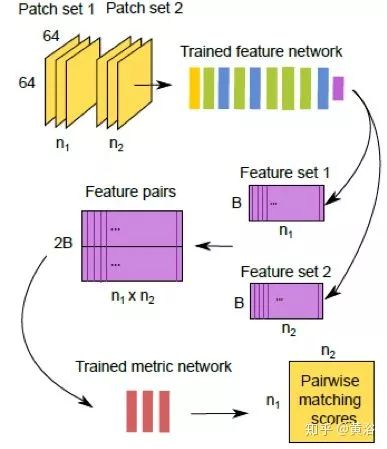

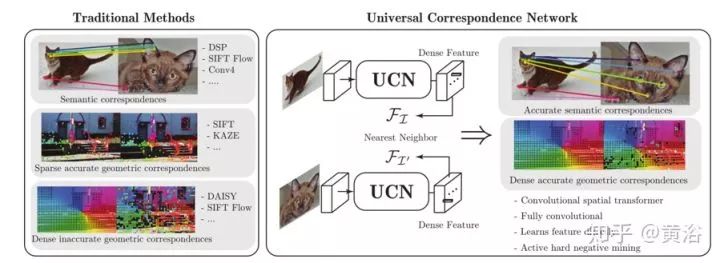

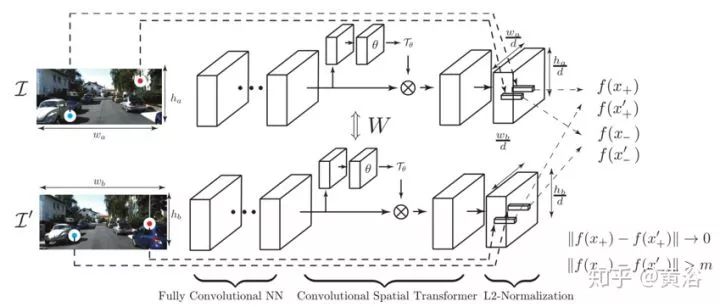

特征匹配

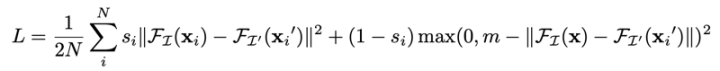

MatchNet【3】

UCN【4】

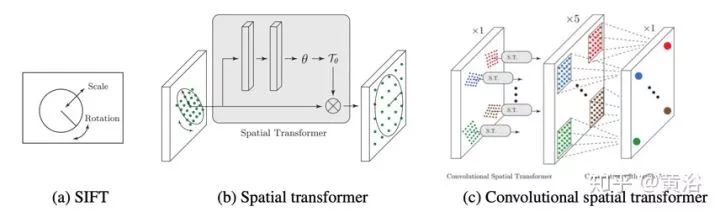

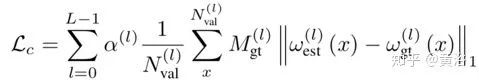

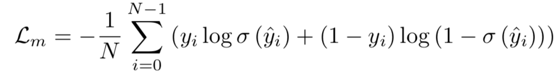

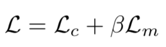

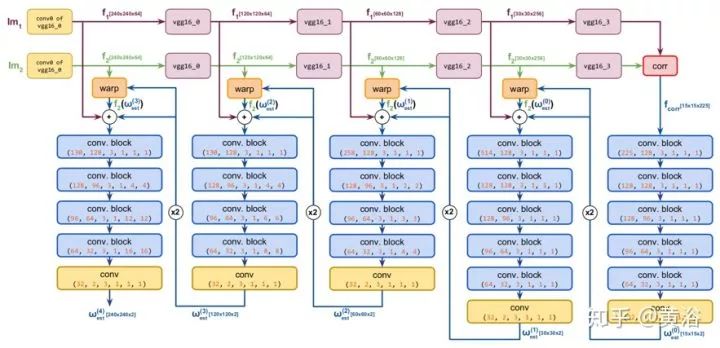

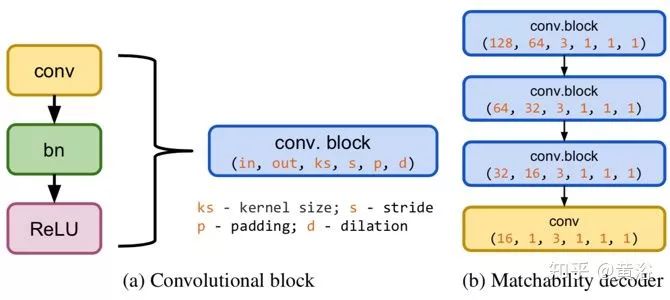

DGC-Net【5】

参考文献

1. E. Simo-Serra et al., “Discriminative learning of deep convolutional feature point descriptors”. ICCV 2015 2. K Yi et al.,“Learned Invariant Feature Transform”, arXiv 1603.09114, 2016 3. X Xu et al.,“MatchNet: Unifying Feature and Metric Learning for Patch-Based Matching”, CVPR 2015 4. C Choyet al., “Universal Correspondence Network”,NIPS 20165. I Melekhov et al, “DGC-Net: Dense Geometric Correspondence Network”, CVPR 2019

双一流高校研究生团队创建 ↓

专注于计算机视觉原创并分享相关知识 ☞

整理不易,点赞三连!

评论