点击上方“小白学视觉”,选择加"星标"或“置顶”

重磅干货,第一时间送达

Pytorch有什么节省内存(显存)的小技巧?

在用pytorch实现一个tensorflow project的时候遇到了GPU显存超出 (out of memory) 的问题,不知道有什么优化方法。

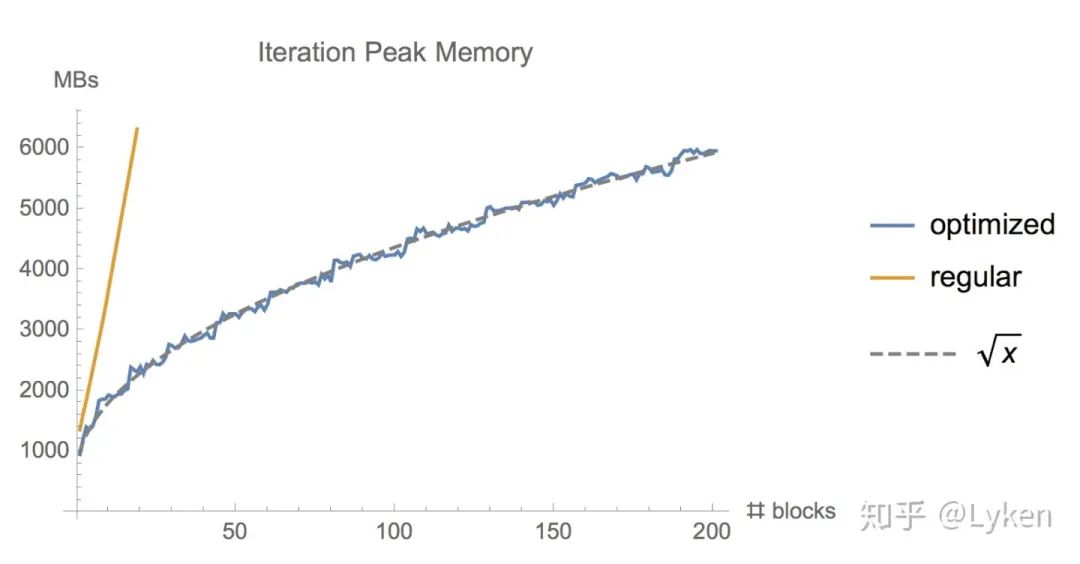

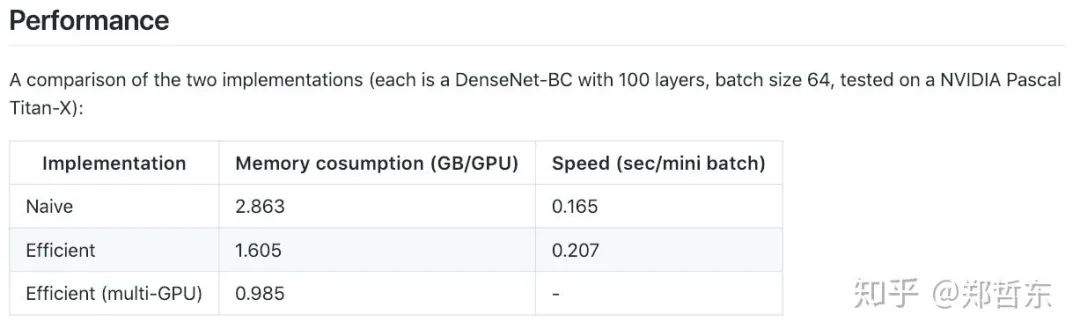

https://www.zhihu.com/question/274635237/answer/755102181咦,大家都没看过陈天奇的 Training Deep Nets with Sublinear Memory Cost (https://arxiv.org/abs/1604.06174)吗?训练 CNN 时,Memory 主要的开销来自于储存用于计算 backward 的 activation,一般的 workflow 是这样的 对于一个长度为 N 的 CNN,需要 O(N) 的内存。这篇论文给出了一个思路,每隔 sqrt(N) 个 node 存一个 activation,中需要的时候再算,这样显存就从 O(N) 降到了 O(sqrt(N))。对于越深的模型,这个方法省的显存就越多,且速度不会明显变慢。PyTorch 我实现了一版,有兴趣的同学可以来试试 https://github.com/Lyken17/pytorch-memongerhttps://www.zhihu.com/question/274635237/answer/5736336621. 同意 @Jiaming, 尽可能使用inplace操作, 比如relu 可以使用 inplace=True 。一个简单的使用方法,如下:def inplace_relu(m): classname = m.__class__.__name__ if classname.find('ReLU') != -1: m.inplace=True

model.apply(inplace_relu)

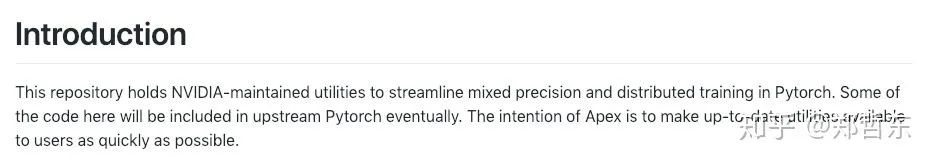

2. 进一步,比如ResNet 和 DenseNet 可以将 batchnorm 和relu打包成inplace,在bp时再重新计算。使用到了pytorch新的checkpoint特性,有以下两个代码。由于需要重新计算bn后的结果,所以会慢一些。3. 每次循环结束时 删除 loss,可以节约很少显存,但聊胜于无。可见如下issue:Tensor to Variable and memory freeing best practices:https://discuss.pytorch.org/t/tensor-to-variable-and-memory-freeing-best-practices/6000/24. 使用float16精度混合计算。我用过 @NVIDIA英伟达apex,很好用,可以节约将近50%的显存,但是要小心一些不安全的操作如 mean和sum,溢出fp16。NVIDIA/apex(https://github.com/NVIDIA/apex)补充:最近我也尝试在我CVPR19的GAN模型中加入fp16的训练,可以从15G的显存需求降到约10G,这样大多数1080Ti等较为常见的显卡就可以训练了。欢迎大家star一波:https://github.com/NVlabs/DG-Net5. 对于不需要bp的forward,如validation 请使用 torch.no_grad , 注意model.eval() 不等于 torch.no_grad() 请看如下讨论:https://github.com/NVlabs/DG-Net6. torch.cuda.empty_cache() 这是del的进阶版,使用nvidia-smi 会发现显存有明显的变化。但是训练时最大的显存占用似乎没变。大家可以试试。How can we release GPU memory cache?https://discuss.pytorch.org/t/how-can-we-release-gpu-memory-cache/1453把一个batchsize=64分为两个32的batch,两次forward以后,backward一次。但会影响 batchnorm等和batchsize相关的层。老外写的提高pytorch效率的方法,包含data prefetch等Optimizing PyTorch training code:https://www.sagivtech.com/2017/09/19/optimizing-pytorch-training-code/

下载1:OpenCV-Contrib扩展模块中文版教程

在「小白学视觉」公众号后台回复:扩展模块中文教程,即可下载全网第一份OpenCV扩展模块教程中文版,涵盖扩展模块安装、SFM算法、立体视觉、目标跟踪、生物视觉、超分辨率处理等二十多章内容。在「小白学视觉」公众号后台回复:Python视觉实战项目,即可下载包括图像分割、口罩检测、车道线检测、车辆计数、添加眼线、车牌识别、字符识别、情绪检测、文本内容提取、面部识别等31个视觉实战项目,助力快速学校计算机视觉。在「小白学视觉」公众号后台回复:OpenCV实战项目20讲,即可下载含有20个基于OpenCV实现20个实战项目,实现OpenCV学习进阶。交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~