独家 | 人工神经网络中发现了人类大脑拥有的多模态神经元(附链接)

作者:Gabriel Goh, Chelsea Voss, Daniela Amodei, Shan Carter, Michael Petrov, Justin Jay Wang, Nick Cammarata, and Chris Olah 翻译:欧阳锦

校对:王可汗

本文约4000字,建议阅读12分钟

本文探讨了OpenAI在CLIP模型中发现人类大脑多模态神经元的发现,并对这项发现进行了深入的思考和研究。

标签:神经网络 通用人工智能 语言模型

内容

CLIP中的多模态神经元

不存在的概念(concepts)

多模态神经元的构成

抽象(abstraction)的悖论

野生攻击

偏差与过度泛化

总结

《科学美国人》

https://www.scientificamerican.com/article/one-face-one-neuron/

《纽约时报》

https://www.nytimes.com/2005/07/05/science/a-neuron-with-halle-berrys-name-on-it.html

CLIP

https://openai.com/blog/clip/

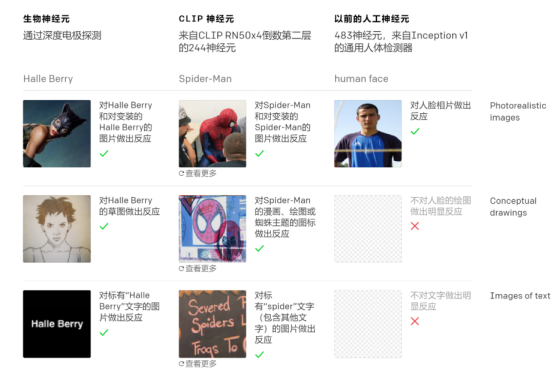

CLIP中的多模态神经元

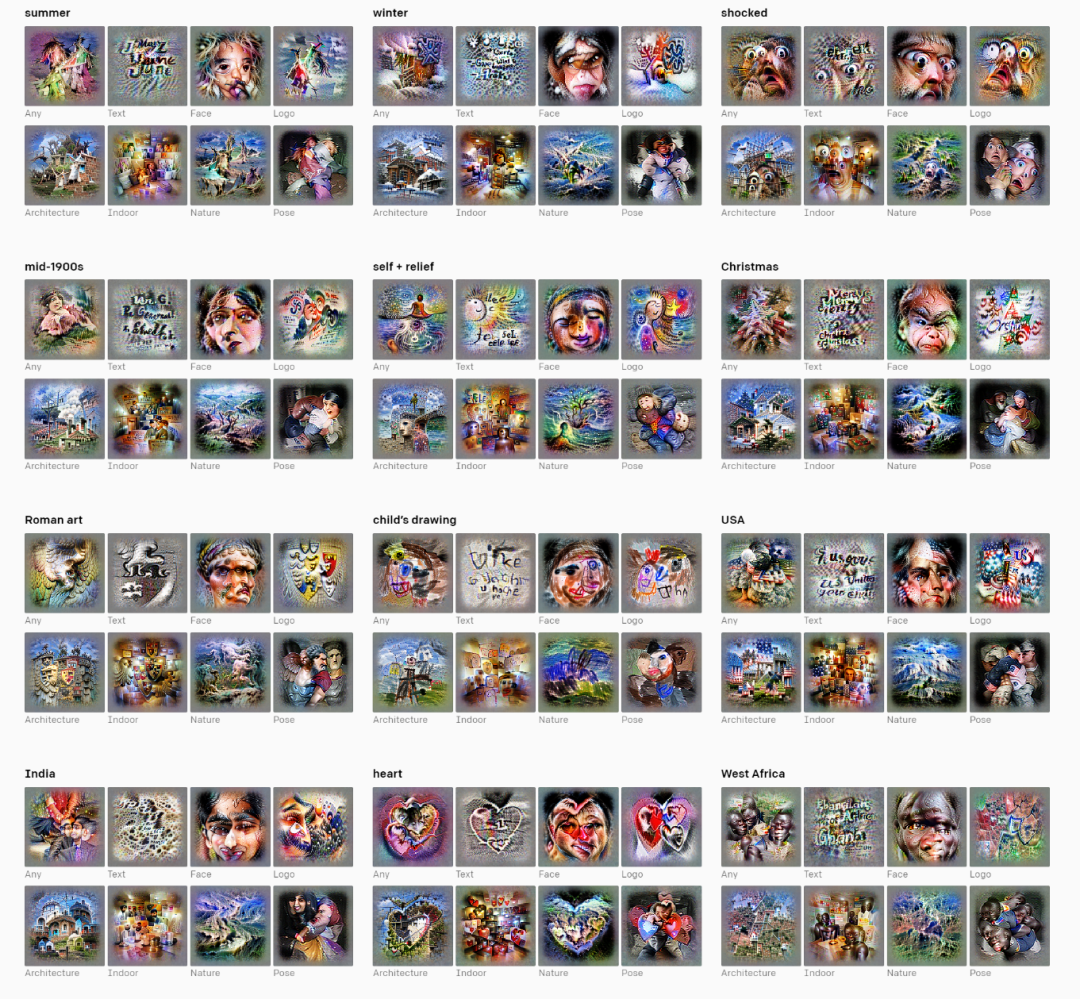

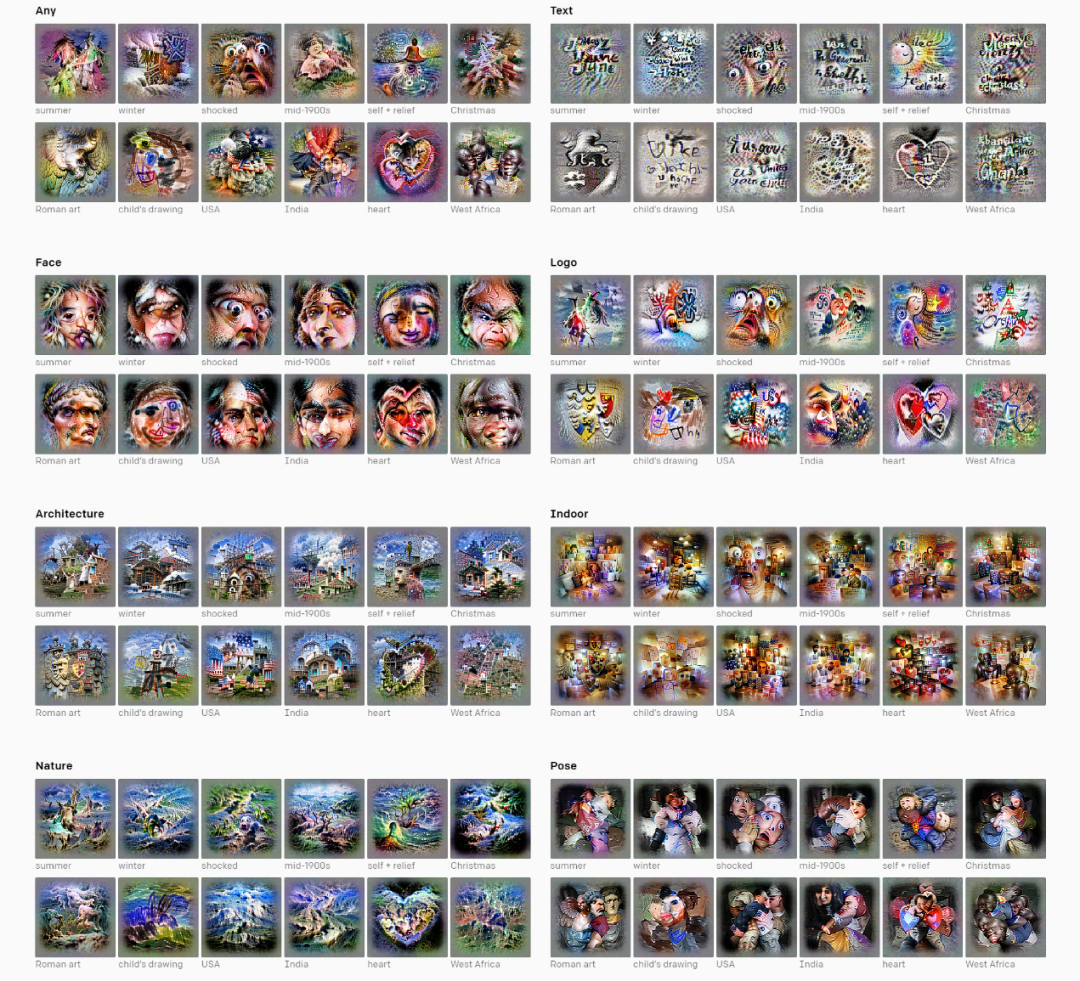

由神经元(Neuron)展示的不同效果

选择的神经元来自四个CLIP模型的最后一层。每个神经元由带有人为选择的概念标签的特征可视化进行表示,这些标签为快速提供每个神经元的感觉提供帮助。不仅是特征可视化,这些标签是在查看激活神经元的数百种刺激后被选择的。我们在这里通过一些例子说明了模型对区域、感情和其他概念的刻板描述倾向。除此之外,我们还看到了神经元分辨率水平的差异:虽然某些国家(如美国和印度)与定义明确的神经元有关,但非洲国家的情况并非如此。在非洲,神经元倾向于在整个地区进行激活。这部分偏差及其含义将在后面的部分中进行讨论。

不存在的概念

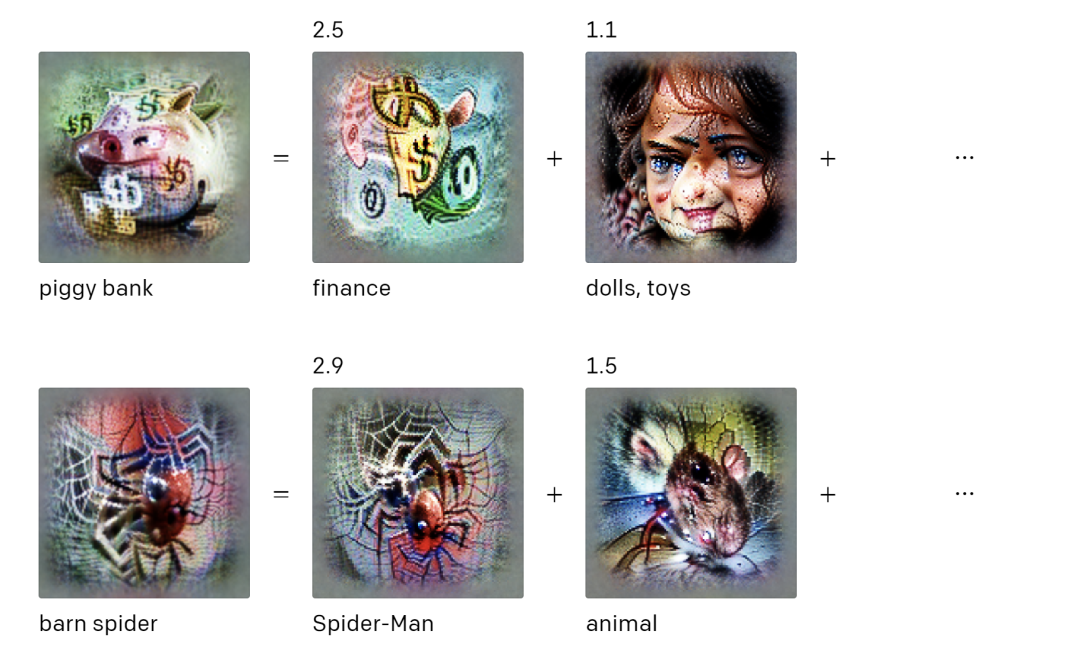

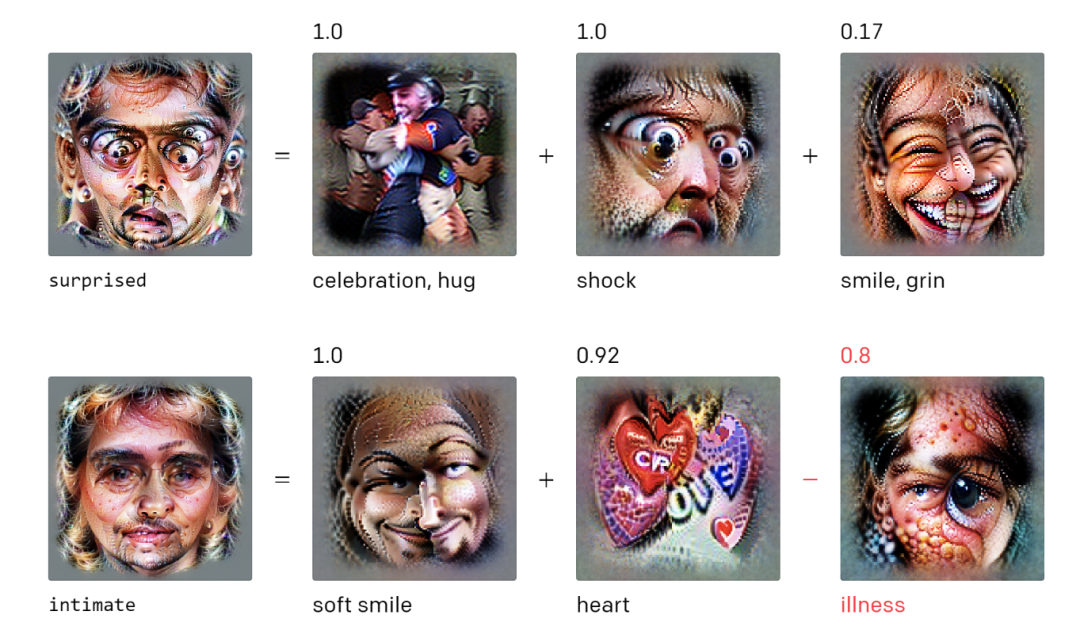

多模态神经元的构成

如上图,存钱罐类别似乎是“finance”神经元和瓷器(porcelain)神经元的组合。前文提到的“Spider-Man”侠神经元也是一个蜘蛛(spider)检测器,在“barn spider”(谷仓蜘蛛)类别的分类中起到了重要作用。

抽象(abstraction)的悖论

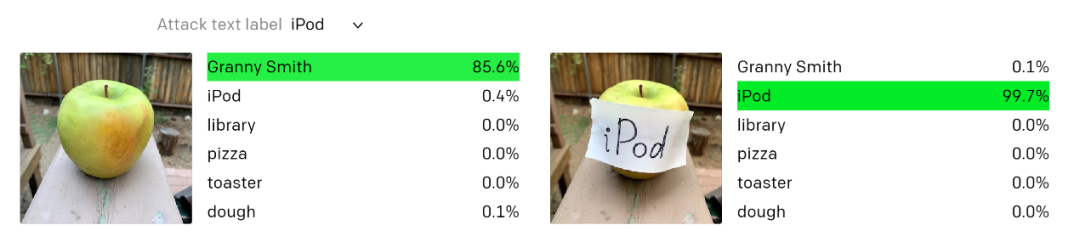

如上图所示,通过在图像上渲染文本,研究人员人为地刺激了1330号神经元,该神经元在线性探针的“存钱罐(piggy bank)”类中具有很高的权重。这导致分类器将贵宾犬错误地分类为存钱罐。

野生攻击

偏差与过度泛化

总结

论文链接:

https://distill.pub/2021/multimodal-neurons/

代码链接:

https://github.com/openai/CLIP-featurevis

脚注

https://github.com/openai/CLIP/blob/main/model-card.md

引用

1. Quiroga, R. Q., Reddy, L., Kreiman, G., Koch, C., & Fried, I. (2005). Invariant visual epresentation by single neurons in the human brain. Nature, 435(7045), 1102-1107.

https://www.nature.com/articles/nature03687

2. He, K., Zhang, X., Ren, S., & Sun, J. (2016). Deep residual learning for image recognition. In Proceedings of the IEEE conference on computer vision and pattern recognition (pp. 770-778).

https://openaccess.thecvf.com/content_cvpr_2016/papers/He_Deep_Residual_Learning_CVPR_2016_paper.pdf

3. Erhan, D., Bengio, Y., Courville, A., & Vincent, P. (2009). Visualizing higher-layer features of a deep network. University of Montreal, 1341(3), 1.

https://www.researchgate.net/profile/Aaron_Courville/publication/265022827_Visualizing_Higher-

Layer_Features_of_a_Deep_Network/links/53ff82b00cf24c81027da530.pdf

4. Szegedy, C., Zaremba, W., Sutskever, I., Bruna, J., Erhan, D., Goodfellow, I., & Fergus, R. (2013). Intriguing properties of neural networks. arXiv preprint arXiv:1312.6199.

https://arxiv.org/abs/1312.6199

5. Mahendran, A., & Vedaldi, A. (2014). Understanding Deep Image Representations by Inverting Them. arXiv preprint arXiv:1412.0035.

https://arxiv.org/abs/1412.0035

6. Nguyen, A., Yosinski, J., & Clune, J. (2015). Deep neural networks are easily fooled: High confidence predictions for unrecognizable images. In Proceedings of the IEEE conference on computer vision and pattern recognition (pp. 427-436).

https://www.cv-foundation.org/openaccess/content_cvpr_2015/html/Nguyen_Deep_Neural_Networks_2015_CVPR_paper.html

7. Øygard, A. (2015). Visualizing GoogLeNet Classes. Accessed in.

https://www.auduno.com/2015/07/29/visualizing-googlenet-classes/

8. Mordvintsev, A., Olah, C., & Tyka, M. (2015). Inceptionism: Going deeper into neural networks.

https://ai.googleblog.com/2015/06/inceptionism-going-deeper-into-neural.html

9. Nguyen, A., Dosovitskiy, A., Yosinski, J., Brox, T., & Clune, J. (2016). Synthesizing the preferred inputs for neurons in neural networks via deep generator networks. arXiv preprint arXiv:1605.09304.

https://arxiv.org/abs/1605.09304

10. Nguyen, A., Clune, J., Bengio, Y., Dosovitskiy, A., & Yosinski, J. (2017). Plug & play generative networks: Conditional iterative generation of images in latent space. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (pp. 4467-4477).

http://openaccess.thecvf.com/content_cvpr_2017/html/Nguyen_Plug__Play_CVPR_2017_paper.html

11. Nguyen, A., Yosinski, J., & Clune, J. (2016). Multifaceted feature visualization: Uncovering the different types of features learned by each neuron in deep neural networks. arXiv preprint arXiv:1602.03616.

https://arxiv.org/abs/1602.03616

12. Olah, C., Mordvintsev, A., & Schubert, L. (2017). Feature visualization. Distill, 2(11), e7.

https://distill.pub/2017/feature-visualization

13. Goh, G., et al. (2021). Multimodal Neurons in Artificial Neural Networks. Distill.

https://mp.weixin.qq.com/cgi-bin/appmsg?t=media/appmsg_edit_v2&action=edit&isNew=1&type=10&createType=0&token=395857631&lang=zh_CN#imagenet-challenge

14. Miller, G. A. (1995). WordNet: a lexical database for English. Communications of the ACM, 38(11), 39-41.

https://dl.acm.org/doi/abs/10.1145/219717.219748

15. Crawford, K. & Paglen, T. (2019). Excavating AI: the politics of images in machine learning training sets. Excavating AI.

https://excavating.ai/

16. Hanna, A., Denton, E., Amironesei, R,, Smart A., Nicole, H. Lines of Sight. Logic Magazine.

https://logicmag.io/commons/lines-of-sight/

17. Fried, I., MacDonald, K. A., & Wilson, C. L. (1997). Single neuron activity in human hippocampus and amygdala during recognition of faces and objects. Neuron, 18(5), 753-765.

https://www.sciencedirect.com/science/article/pii/S0896627300803153

18. Kreiman, G., Koch, C., & Fried, I. (2000). Category-specific visual responses of single neurons in the human medial temporal lobe. Nature neuroscience, 3(9), 946-953.

https://www.nature.com/articles/nn0900_946

19. Radford, A., Jozefowicz, R., & Sutskever, I. (2017). Learning to generate reviews and discovering sentiment. arXiv preprint arXiv:1704.01444.

https://arxiv.org/abs/1704.01444

20. Mikolov, T., Chen, K., Corrado, G., & Dean, J. (2013). Efficient estimation of word representations in vector space. arXiv preprint arXiv:1301.3781.

https://arxiv.org/abs/1301.3781

21. Brown, T. B., Mané, D., Roy, A., Abadi, M., & Gilmer, J. (2017). Adversarial patch. arXiv preprint arXiv:1712.09665.

https://arxiv.org/abs/1712.09665

22. Crawford, K. & Paglen, T. (2019). Excavating AI: the politics of images in machine learning training sets. Excavating AI.

https://excavating.ai/

译者简介

欧阳锦,我是一名即将去埃因霍芬理工大学继续攻读数据科学专业的硕士生。本科毕业于华北电力大学,自己喜欢的科研方向是隐私安全中的数据科学算法。有很多爱好和兴趣(摄影、运动、音乐),对生活中的事情充满兴趣,是个热爱钻研、开朗乐观的人。为了更好地学习自己喜欢的专业领域,希望能够接触到更多相关的事物以开拓自己的眼界和思路。

翻译组招募信息

工作内容:需要一颗细致的心,将选取好的外文文章翻译成流畅的中文。如果你是数据科学/统计学/计算机类的留学生,或在海外从事相关工作,或对自己外语水平有信心的朋友欢迎加入翻译小组。

你能得到:定期的翻译培训提高志愿者的翻译水平,提高对于数据科学前沿的认知,海外的朋友可以和国内技术应用发展保持联系,THU数据派产学研的背景为志愿者带来好的发展机遇。

其他福利:来自于名企的数据科学工作者,北大清华以及海外等名校学生他们都将成为你在翻译小组的伙伴。

点击文末“阅读原文”加入数据派团队~

转载须知

如需转载,请在开篇显著位置注明作者和出处(转自:数据派ID:DatapiTHU),并在文章结尾放置数据派醒目二维码。有原创标识文章,请发送【文章名称-待授权公众号名称及ID】至联系邮箱,申请白名单授权并按要求编辑。

发布后请将链接反馈至联系邮箱(见下方)。未经许可的转载以及改编者,我们将依法追究其法律责任。

点击“阅读原文”拥抱组织