Meta AI 新研究,统一模态的自监督新里程碑

大数据文摘授权转载自数据实战派

作者:青苹果

虽然 AI 领域不断涌现出新的突破和进展,却始终难以逃离单一领域的束缚——一种用于个性化语音合成的新颖方法,却并不能用于识别人脸的表情。

为了解决这个问题,不少研究人员正在致力于开发功能更强大、应用更广泛的 AI 工具:无论在口头、书面还是视觉材料上,都可以实现自主学习。

传统训练 AI 模型正确理解某些内容的方法是,提供大量(比如数百万个)有标记的例子。

试想一下,一幅标有猫的部分特征的图片,一段与演讲者的对话或摘录的文本,等等。但这种方法日趋淘汰,因为研究人员发现,手动创建训练下一代 AI 所需的数据库已不再可行。试想一下,谁想给 5000 万张猫的照片贴上标签呢?好吧,可能有几个人;但是谁又愿意给 5000 万张常见水果和蔬菜的照片贴上标签呢?答案明显是否定的。

目前,最有前景的一些 AI 系统采用的就是所谓的“自我监督”(self - supervision):模型可以在大量无标签数据(比如人们互动的书籍或视频)中运行,并建立自己对系统规则的结构化理解。例如,模型通过阅读 1000 本书,会自主学习语法结构,包括单词的相对位置,而无需任何人告诉它什么是宾语、冠词或逗号……这些完全可以从大量的例子中推理得出。

就在近日,基于上述理论,来自 Meta 的研究团队发表了一篇题为“data2vec: A General Framework for Self-supervised Learning in Speech, Vision and Language”的论文。

在这项研究中,开发人员构建了一个名为 data2vec 的框架,可以跨语音处理、NLP 和计算机视觉(CV, Computer Vision)使用相同的学习方法,极大地克服了单一开发模式的缺陷,提高了模型的通用性能。

其核心思想是,在使用标准 Transformer 体系结构的自蒸馏设置中,基于输入的掩码视图(masked view)预测完整输入数据的潜在表示。data2vec 并非是预测特定模式的目标,比如像单词、视觉 tokens 或语言单元等,而是预测包含来自整个输入信息的上下文潜在表示。通过在语音识别、图像分类和自然语言理解的主要基准上进行实验,有力证明了该方法的技术水平和优异性能。

从直觉上看,这更像是人们学习的方式,这也是研究人员喜欢它的原因之一。但是这些模型仍然趋向于单模态,也就是说,你为建立语音识别的半监督学习系统所做的所有工作根本不适用于图像分析,两者无疑是大相径庭。从而,这就更加突显出 Meta 这项最新研究的意义所在。

然而从本质上看,data2vec 的想法就是建立一个 AI 框架,然后以更抽象的方式学习。这便意味着一切从零开始,你可以准备一些可阅读的书籍、可扫描的图像或有声的读物供其训练,以使模型达到学习这些知识的目的。这有点像从一粒种子开始,给它不同植物的生存环境和营养条件,使其开出不同的花朵,如水仙、三色堇或郁金香。

总而言之,团队提出的方法就是将掩码预测与潜在目标表示的学习相结合,只不过是通过使用多个网络层作为目标,对后者进行推广,并表明该方法适用于多种模式。

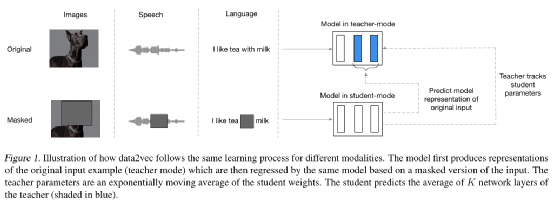

具体来说,如 图 1 所示,团队成员需要训练一个现成的可以在教师模式和学生模式中使用的 Transformer 网络:首先需要构建完整的输入数据表示,其目的是充当学习任务中的目标(教师模式)。接下来,对输入样本的掩码版本进行编码,用它预测完整的数据表示(学生模式)。教师的权重是学生权重指数衰减的平均值。由于不同的模式有着截然不同的输入,例如,像素和单词,因此,团队采用了特定于模式的特征编码器和掩码策略。

在整体架构上,采用标准 Transformer 体系结构,并沿用先前的工作对输入数据进行特定模式的编码。

对于 CV,团队成员采用了 ViT 策略,将图像编码为一系列补丁序列,每个补丁跨越 16x16 像素,输入到线性变换之中。语音数据使用多层一维 CNN 进行编码,该网络将 16 kHz 波形映射为 50 Hz 表示。对文本进行预处理以获得子词单元,然后通过学习得到的嵌入向量将其嵌入到分布空间中。

在训练目标上,基于掩码样本的编码训练模型,以预测原始未掩码训练样本的模型表示。需要注意的是,团队仅针对掩码的时间步长预测模型表示。预测的表示是一种上下文的表示,不仅对特定的时间步长进行编码,还对来自样本的其他信息进行编码,这是由于在 Transformer 网络中使用了自注意力机制(Self-attention)。因此,相比于预测缺乏上下文信息目标的 BERT、wav2vec 2.0 或BEiT、MAE、SimMIM 和 MaskFeat 模型,这是一条重要的区别。

在实验设置上,研究团队采用了两种尺寸的模型:data2vec Base 和 data2vec Large,包含 H=768 或 1024 两个隐藏维度的 L=12 或 24 的 Transformer blocks。

在用各种数据语料库对 data2vec 进行训练后,测试的结果表明,在该模式上,相比于类似规模的专用模型,它具有一定的竞争力,甚至表现得更加出色。(也就是说,如果所有模型都被限制在 100 兆字节,data2vec 会做得更好——随着模型规模的增大,专用模型取胜的几率会更大。)

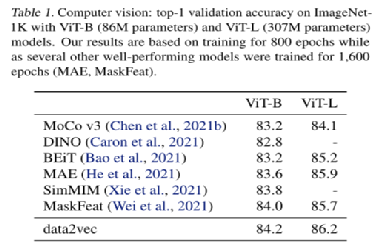

具体而言,为了评估该方法在 CV 领域的应用,团队成员在 ImageNet-1K 训练集的图像上预训练 data2vec,并使用相同基准的标记数据对图像分类的结果模型进行微调。结果如表 1 所示,data2vec 优于之前使用 ViT-B 和 ViT-L 的研究工作。与预测局部目标的方法相比,在掩码预测设置中预测上下文的潜在表示可以很好地执行。

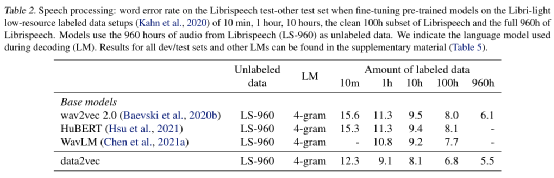

而在语音处理方面,团队成员使用 Librispeech (LS-960)的 960 小时语音音频数据对 data2vec 进行预训练。这个数据集包含了从英语有声读物中获取的相对清晰的语音音频,是语音社区的标准基准。

为了了解不同资源设置下的性能,团队使用不同数量的标记数据(从 10 分钟到 960 小时不等)对自动语音识别模型进行了微调。表 2 显示了所有标记数据设置的改进,很明显,标记数据为 10 分钟时,收益达到最大值。

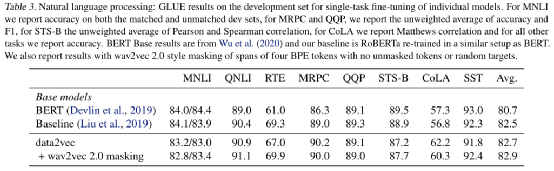

最后,为了了解 data2vec 在语言方面的表现,研究团队采用了与BERT相同的训练设置,通过对图书语料库和英语维基百科的数据进行预训练。结果如表 3 所示,data2vec 的性能优于 RoBERTa 基线。据团队所知,这是首个不使用离散单元(单词,子单词,字符或字节)作为训练目标而成功完成预训练的 NLP 模型。

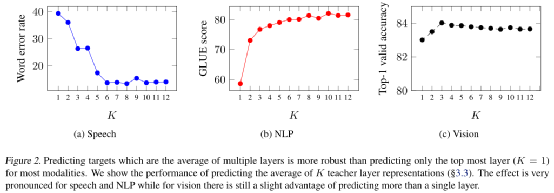

此外,研究团队还进行了一系列的消融实验,如图 2 所示,对于大多数模式来说,预测多个层的平均目标要比只预测最顶层(K = 1)更加稳健。使用所有层通常是一个不错的选择,并且仅比仔细调整的 K 值稍差一点。现代神经网络往往在多个层上构建特征,并在不同的层上提取不同类型的特征。显然,使用来自多个层的特征既丰富了自监督任务,又提高了准确性。

在一篇博客文章中,该团队写道:“这种方法的核心思想是更广泛地学习。AI 应该能够学会做多种类型的任务,包括那些完全不熟悉的任务。

我们也殷切希望 data2vec 能够让我们更接近这样的一个世界,计算机只需要很少的标记数据即可完成任务。”

除此之外,首席执行官马克·扎克伯格(Mark Zuckerberg)在研究中评论道,“人们通过视觉、声音和文字的组合来体验世界,这样的系统有朝一日可能会像我们一样理解世界”。

显然,这仍然属于早期研究的范畴,所以不要期待传说中的“通用人工智能”(GAI, General Artificial Intelligence)会突然出现。

不过,相比于当下我们所使用的支离破碎的微智能(micro-intelligence),拥有一个具有通用学习结构的 AI,以胜任处理各种领域和数据类型,这似乎是一个更完美、更优雅的解决方案。